Нормирование погрешностей средств измерений

Нормирование метрологических характеристик средств измерений и заключается в установлении границ для отклонений реальных значений параметров средств измерений от их номинальных значений.

Каждому средству измерений приписываются некоторые номинальные характеристики. Действительные же характеристики средств измерений не совпадают с номинальными, что и определяет их погрешности.

Обычно нормирующее значение принимают равным:

1. большему из пределов измерений, если нулевая отметка расположена на краю или вне диапазона измерения;

2. сумме модулей пределов измерения, если нулевая отметка расположена внутри диапазона измерения;

3. длине шкалы или её части, соответствующей диапазону измерения, если шкала существенно неравномерна (например, у омметра);

4. номинальному значению измеряемой величины, если таковое установлено (например, у частотомера с номинальным значением 50 Гц);

5. модулю разности пределов измерений, если принята шкала с условным нулём (например, для температуры), и т.д.

Чаще всего за нормирующее значение принимают верхний предел измерений данного средства измерений.

Отклонения параметров средств измерений от их номинальных значений, вызывающие погрешность измерений, не могут быть указаны однозначно, поэтому для них должны быть установлены предельно допускаемые значения.

Указанное нормирование является гарантией взаимозаменяемости средств измерений.

Нормирование погрешностей средств измерений заключается в установлении предела допускаемой погрешности.

Под этим пределом понимается наибольшая (без учёта знака) погрешность средства измерения, при которой оно может быть признано годным и допущено к применению.

Подход к нормированию погрешностей средств измерений заключается в следующем:

1. в качестве норм указывают пределы допускаемых погрешностей, включающие в себя и систематические, и случайные составляющие;

2. порознь нормируют все свойства средств измерений, влияющие на их точность.

Стандарт устанавливает ряды пределов допускаемых погрешностей. Этой же цели служит установление классов точности средств измерений.

Классы точности средств измерений

Класс точности – это обобщенная характеристика СИ, выражаемая пределами допускаемых значений его основной и дополнительной погрешностей, а также другими характеристиками, влияющими на точность. Класс точности не является непосредственной оценкой точности измерений, выполняемых этим СИ, поскольку погрешность зависит еще от ряда факторов: метода измерений, условий измерений и т.д. Класс точности лишь позволяет судить о том, в каких пределах находится погрешность СИ данного типа. Общие положения деления средств измерений по классу точности устанавливает ГОСТ 8.401–80.

Пределы допускаемой основной погрешности, определяемые классом точности, – это интервал, в котором находится значение основной погрешности СИ.

Классы точности СИ устанавливаются в стандартах или технических условиях. Средство измерения может иметь два и более класса точности. Например, при наличии у него двух или более диапазонов измерений одной и той же физической величины ему можно присваивать два или более класса точности. Приборы, предназначенные для измерения нескольких физических величин, также могут иметь различные классы точности для каждой измеряемой величины.

Пределы допускаемых основной и дополнительной погрешностей выражают в форме приведенных, относительных или абсолютных погрешностей. Выбор формы представления зависит от характера изменения погрешностей в пределах диапазона измерений, а также от условий применения и назначения СИ.

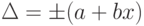

Пределы допускаемой абсолютной основной погрешности устанавливаются по одной из формул:  или

или  , где x– значение измеряемой величины или число делений, отсчитанное по шкале; a, b – положительные числа, не зависящие от х. Первая формула описывает чисто аддитивную погрешность, а вторая – сумму аддитивной и мультипликативной погрешностей.

, где x– значение измеряемой величины или число делений, отсчитанное по шкале; a, b – положительные числа, не зависящие от х. Первая формула описывает чисто аддитивную погрешность, а вторая – сумму аддитивной и мультипликативной погрешностей.

В технической документации классы точности, установленные в виде абсолютных погрешностей, обозначают, например, "Класс точности М", а на приборе – буквой "М". Для обозначения используются прописные буквы латинского алфавита или римские цифры, причём меньшие пределы погрешностей должны соответствовать буквам, находящимся ближе к началу алфавита, или меньшим цифрам. Пределы допускаемой приведенной основной погрешности определяются по формуле  , где xN – нормирующее значение, выраженное в тех же единицах, что и

, где xN – нормирующее значение, выраженное в тех же единицах, что и  ; p – отвлеченное положительное число, выбираемое из ряда значений:

; p – отвлеченное положительное число, выбираемое из ряда значений:

Нормирующее значение xN устанавливается равным большему из пределов измерений (или модулей) для СИ с равномерной, практически равномерной или степенной шкалой и для измерительных преобразователей, для которых нулевое значение выходного сигнала находится на краю или вне диапазона измерений. Для СИ, шкала которых имеет условный нуль, равно модулю разности пределов измерений.

Для приборов с существенно неравномерной шкалой xN принимают равным всей длине шкалы или ее части, соответствующей диапазону измерении. В этом случае пределы абсолютной погрешности выражают, как и длину шкалы, в единицах длины, а на средстве измерений класс точности условно обозначают, например, в виде значка  , где 0,5 – значение числа р (рис. 3.1).

, где 0,5 – значение числа р (рис. 3.1).