Простое определение представительности выборки могло бы выглядеть так: «Представительной считается такая обучающая выборка  , которая в заданном пространстве признаков и заданном классе решающих функций позволяет построить правило распознавания новых объектов (контрольной выборки

, которая в заданном пространстве признаков и заданном классе решающих функций позволяет построить правило распознавания новых объектов (контрольной выборки  ) с ошибкой, не превышающей заданной величины».

) с ошибкой, не превышающей заданной величины».

К сожалению, такое определение логично, но не конструктивно. Обучение делается на имеющемся материале, а проверка качества обучения будет делаться на материале, которого в процессе обучения нет и о котором нет никакой предварительной информации. Так что проверить, хорошо ли она будет распознаваться, не возможно.

Как всегда, в условиях недостатка информации приходится привлекать дополнительные эмпирические гипотезы. В данном случае используется следующее предположение: закономерная связь описывающих признаков  с целевым признаком

с целевым признаком  на множестве обучающих

на множестве обучающих  и контрольных

и контрольных  объектов одна и та же. Эта гипотеза подтверждается, например, при следующих условиях: связь между

объектов одна и та же. Эта гипотеза подтверждается, например, при следующих условиях: связь между  и

и  на генеральной совокупности объектов

на генеральной совокупности объектов  подчиняется закономерности типа

подчиняется закономерности типа  , и выборки

, и выборки  и

и  каждая в отдельности хорошо представляют эту генеральную совокупность. Тогда на них наблюдается та же закономерность

каждая в отдельности хорошо представляют эту генеральную совокупность. Тогда на них наблюдается та же закономерность  и

и  . Это позволит, обучившись на объектах

. Это позволит, обучившись на объектах  , хорошо распознавать и объекты

, хорошо распознавать и объекты  .

.

Прямых доказательств того, выполняются ли эти условия в конкретной реальной задаче, получить нельзя. Можно говорить лишь о косвенных ответах на этот вопрос. Прежде всего, обращается внимание на объем  обучающей выборки

обучающей выборки  . Считается, что чем больше

. Считается, что чем больше  , тем больше вероятность того, что закономерность

, тем больше вероятность того, что закономерность  совпадает с закономерностью

совпадает с закономерностью  . В общем случае это так, но положиться только на число

. В общем случае это так, но положиться только на число  не позволяет соображение «независимости» выборки, которое хорошо иллюстрирует следующая притча. Приходит геолог к распознавателю, показывает ему два камня и просит построить решающее правило для распознавания образов двух минералов, представленных этой выборкой. Распознаватель ему говорит: «Коллега, ваша обучающая выборка явно недостаточна». — «А сколько образцов вам нужно?» — «Ну, хотя бы по двадцать штук на каждый признак». — «Пожалуйста», — говорит геолог и через некоторое время приносит нужное количество образцов каждого минерала. «Вот теперь все в порядке! — говорит распознаватель. — А где вы их взяли?» — «Я просто разбил те камни на нужное число частей». — «Нет, так нельзя! — говорит распознаватель. — Нужно, чтобы каждый кусочек был взят независимо от других, был бы частью других более крупных образований». — «А как мне узнать, что кусочки минерала, которые я найду в экспедиции независимо один от другого, не будут на самом деле осколками одного и того же более крупного образования?» Ответа на этот вопрос нет ни у геолога, ни у распознавателя.

не позволяет соображение «независимости» выборки, которое хорошо иллюстрирует следующая притча. Приходит геолог к распознавателю, показывает ему два камня и просит построить решающее правило для распознавания образов двух минералов, представленных этой выборкой. Распознаватель ему говорит: «Коллега, ваша обучающая выборка явно недостаточна». — «А сколько образцов вам нужно?» — «Ну, хотя бы по двадцать штук на каждый признак». — «Пожалуйста», — говорит геолог и через некоторое время приносит нужное количество образцов каждого минерала. «Вот теперь все в порядке! — говорит распознаватель. — А где вы их взяли?» — «Я просто разбил те камни на нужное число частей». — «Нет, так нельзя! — говорит распознаватель. — Нужно, чтобы каждый кусочек был взят независимо от других, был бы частью других более крупных образований». — «А как мне узнать, что кусочки минерала, которые я найду в экспедиции независимо один от другого, не будут на самом деле осколками одного и того же более крупного образования?» Ответа на этот вопрос нет ни у геолога, ни у распознавателя.

При одном и том же числе  представительность выборки как свойство, обеспечивающее хорошее качество обучения, будет разным в зависимости от того, какие части генеральной совокупности она представляет. Если распознается два образа, то не важно, как выглядит генеральная совокупность во всем пространстве признаков. Гораздо важнее, как она выглядит в районе границы между образами. И если есть возможность планировать эксперимент по набору обучающего материала, то нужно организовать его так, чтобы

представительность выборки как свойство, обеспечивающее хорошее качество обучения, будет разным в зависимости от того, какие части генеральной совокупности она представляет. Если распознается два образа, то не важно, как выглядит генеральная совокупность во всем пространстве признаков. Гораздо важнее, как она выглядит в районе границы между образами. И если есть возможность планировать эксперимент по набору обучающего материала, то нужно организовать его так, чтобы  экспериментов были проведены в критичной зоне пространства, где имеется наибольший риск получить ошибочное решение.

экспериментов были проведены в критичной зоне пространства, где имеется наибольший риск получить ошибочное решение.

Из приведенных здесь рассуждений можно сделать вывод, что назвать определенное число обучающих объектов, необходимых и достаточных для успешного обучения в конкретной задаче распознавания, нельзя. Глубокие теоретические исследования этой проблемы делались в предположении, что природа будет играть с распознавателем по самым коварным правилам — предъявлять в обучающей выборке максимально непредставительный материал [24]. Чтобы преодолеть это нежелание природы открыть истинные закономерности, требуются выборки чрезвычайно большого объема, что делает такие оценки неприемлемыми для практического использования.

При другом подходе оценивался требуемый объем выборки для случая, когда стратегия природы не так коварна и проявляется как в легких, так и в сложных ситуациях. При этом предположении исследуются параметры «средних» случаев и для них получаются оценки необходимых объемов обучающей выборки [109]. Они получаются меньшими, чем для самого плохого случая, но за это уменьшение выборки нужно расплачиваться риском столкнуться в реальной задаче со стратегией такой сложности, для которой эта выборка окажется недостаточно представительной.

В условиях такой неопределенности обычно используются различные эвристические приемы для косвенной оценки достаточности обучающей выборки. Если позволяют условия, то процесс обучения делится на два этапа — «предварительного обучения» и «дообучения». На первом этапе строится решающее правило с использованием имеющейся обучающей выборки. Затем система распознавания переводится в режим опытной эксплуатации. Предъявляются объекты контрольной выборки и ведется протокол результатов их распознавания. При появлении ошибки состав обучающей выборки дополняется реализацией, вызвавшей ошибку, и решающее правило корректируется. Так продолжается до тех пор, пока частота появления ошибок не снизится до приемлемого уровня.

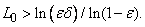

В [4, 25] приводятся оценки необходимого объема дообучающей выборки как функции требуемого качества обучения. Считается, что решающая функция задана хорошо, если при случайном выборе контрольных объектов  подряд следующих реализаций не вносит в нее никаких изменений. Если

подряд следующих реализаций не вносит в нее никаких изменений. Если  — вероятность ошибки распознавания после завершения обучения, то при любых положительных

— вероятность ошибки распознавания после завершения обучения, то при любых положительных  и

и  вероятность

вероятность  того, что

того, что  не превышает

не превышает  , всегда больше величины

, всегда больше величины  , если выполняется следующее неравенство:

, если выполняется следующее неравенство:

Здесь  связано с доверительным числом

связано с доверительным числом  показов без исправления решающего правила соотношением

показов без исправления решающего правила соотношением  , где

, где  — число имевшихся ранее исправлений решающей функции.

— число имевшихся ранее исправлений решающей функции.

Для проверки качества обучения часто применяется метод «скользящего экзамена», состоящий в следующем. Часть  объектов (иногда

объектов (иногда  ) изымается из обучающей выборки, проводится обучение на оставшихся объектах, а изъятые объекты предъявляются для распознавания. Фиксируется число ошибок. Затем эти «контрольные» объекты возвращаются в выборку

) изымается из обучающей выборки, проводится обучение на оставшихся объектах, а изъятые объекты предъявляются для распознавания. Фиксируется число ошибок. Затем эти «контрольные» объекты возвращаются в выборку  , а из нее изымаются другие

, а из нее изымаются другие  объектов, и процедура повторяется до тех пор, пока все

объектов, и процедура повторяется до тех пор, пока все  объектов не побывают в роли контрольных. Если сумма полученных ошибок не превышает заданной величины, то считается, что система обучена хорошо.

объектов не побывают в роли контрольных. Если сумма полученных ошибок не превышает заданной величины, то считается, что система обучена хорошо.