КОНСПЕКТ

лекций проф. Михалева А.И.

по дисциплине «Информационные основы синергетики и нанотехнологий»

ВВЕДЕНИЕ (синергетика-фрагменты)

Синергетика, или теория самоорганизации, сегодня представляется одним из наиболее популярных и перспективных междисциплинарных подходов. Термин синергетика в переводе с греческого означает совместное действие. Введя его, Герман Хакен вкладывал в него два смысла. Первый – теория возникновения новых свойств у целого, состоящего из взаимодействующих объектов. Второй - подход, требующий для своей разработки сотрудничества специалистов из разных областей.

Это, как показало время, привело к замечательному обратному эффекту – синергетика начала оказывать все большее влияние на разные сферы деятельности и вызывать все больший интерес. Сейчас этим подходом интересуются очень многие - от студентов до политиков, от менеджеров до активно работающих исследователей.

Синергетика прошла большой путь. Тридцать лет назад на нее смотрели как на забаву физиков - теоретиков, увидевших сходство в описании многих нелинейных явлений. Двадцать лет назад, благодаря ее концепциям, методам, представления были экспериментально обнаружены многие замечательные явления в физике, химии, биологии, гидродинамике. Сейчас этот междисциплинарный подход все шире используется в стратегическом планировании, при анализе исторических альтернатив, в поиске путей решения глобальных проблем, вставших перед человечеством.

Итак, диада, или бинарная оппозиция, есть элементарная структура анализа. Синтеза на ней не построить. Для синтеза требуется более емкая структура. Примеры из естественных наук подсказывают, что следует обратиться, по меньшей мере, к триадам [23].

Тернарные структуры

Будем называть триадой совокупность из трех элементов, каким-то образом связанных между собой. В зависимости от вида связи различаются следующие типы триад.

Линейные (вырожденные, одномерные), когда все три элемента расположены на одной оси в семантическом пространстве. Например, 1-10-100, дивергенция–параллелизм -конвергенция, левые–центр-правые. Структурно они не богаче, чем диады.

Переходные (гегелевские), характеризуемые известной формулой "тезис–антитезис-синтез". Они лишь провозглашают снятие противоречия, не раскрывая его движущей структуры.

Системные (целостные), единство которых создается тремя элементами одного уровня, каждый из которых может служит мерой совмещения двух других. Все три потенциально равноправны.

В математической статистике сложилось понятие правильности, противостоящее точности, поскольку при описании реальных не вполне детерминированных объектов существуют границы разумной точности. Эта оппозиция примиряется через понятие вероятности, так что математическую статистику можно определить триадой "точность-вероятность-правильность".

Для нечеткой парадигмы это может звучать как "разумность - субъективная уверенность - правильность".

Из истории тринитарного опыта

Как известно, - ничто не ново под луной', или, иными словами, все новое есть хорошо забытое старое. Тернарный опыт человечества достаточно богат, чтобы извлечь из него весомый урок, хотя пока располагается он на периферии современной парадигмы. Однако интерес к нему уже поднимается. появились первые тома международной

библиографии тринитарной литературы [28], где собрано около 6 тысяч работ по триадическим структурам типа nosse-velle-esse, т. е. cognition-acting-being, или познание-действие-бытие, соответствующего нашей семантической формуле рацио-эмоцио-интуицио. Взглянем последовательно на системные триады, сложившиеся в науке, искусстве, религии.

В математике известны три типа математических структур: порядковые, алгебраические, топологические.

Трихотомия физики [29] выделяет теорию элементарных частиц, теорию относительности и квантовую механику, причем каждая из этих областей имеет свою фундаментальную константу.

В биологии часто упоминается триада эволюционной теории "изменчивость – отбор – наследственность".

В лингвистике, согласно П. А. Флоренскому [30], строение слова может быть представлено триадой "морфема-фонема-семема".

У В. В. Набокова встречается такая грустная формула человеческого бытия: неизбежность-невозвратимость-несбыточность [36].

М. А. Волошин пишет, что спасая в своем доме отнюдь не ангелов, он относился к ним без злобы, без страха, без осуждения [37].

Вслед за К. Воннегугом многие авторы цитируют такую молитву: "Господи, дай мне душевный покой, чтобы принимать то, чего я не могу изменить, мужество – изменять то, что могу, и мудрость - всегда отличать одно от другого". Целостными триадами насыщен и русский фольклор: три сына, три героя, три попытки и т. п. И вызрела в нем мудрая пословица - три самых трудных вещи: долги платить, родителей кормить, Боry молиться.

"Подступы к Троице - в любой великой религии, - пишет Г. А. Померанц, - Древнее мышление было триалистичным. Рационализм тяготеет к дуализму. Триада замыкает расходящийся угол, снимает оппозицию" [38]

В Европе идея Единого в трех лицах утвердилась в III веке когда была канонизирована Святая Троица, нераздельная, неслиянная, единосущная. Три ипостаси христианского Бога не нарушают целостного единства, поскольку их различение не переходит в разделение. В то же время различение открывает путь к познанию.

Как пишет К. С. Льюис, "Бог ввел различие внутрь себя, чтобы в единении любви превзойти единство самотождественности" [39].

Образ Святой Троицы проявляется во всем. Так, в христианском богословии с самого начала выделялись три смысла текста: телесный (буквальный, историческо - грамматический), душевный (моральный), духовный (аллегоргическо-мистический) [40].

Различаются три типа икон с изображением девы Марии: указующая, умиляющаяся, молящаяся. Существуют три монашеских обета: "нeстяжательство, безбрачие, послушание".

Тринитиарный архетип можно обнаружить в корнях любой религии. Так, в Индии различают три качества первоначальной материи (Пракрити): Тамас (мрак), Раджа (страсть), Саттва (свет), а у Бога индусов - три лика: Вишну, Шива, Брама [41]. Сами крупнейшие опорные религии мира тоже образуют системную триаду: ислам-христианство-буддизм. А о трех ветвях христианства еще П. И. Новгородцев писал, что в католицизме преобладает юридический аспект, в протестантизме - этический, в православии - принцип любви во Христе [42].

"Троица - место будущей встречи всех высоких религий…Лучшее, достигнутое человеком осознание сверхсистемной структуры своего внутреннего мира и Божьего" [43].

Лекция 1.

ОСНОВНЫЕ ПОНЯТИЯ ДИНАМИЧЕСКОЙ ТЕОРИИ ИНФОРМАЦИИ

Сейчас имеется несколько (даже много) определений понятия "информация" и ни одно из них не является общепринятым. Это естественно, поскольку общепризнанные определения появляются в науке, когда она становится классической и перестает развиваться. О науке об информации этого, к счастью, сказать нельзя. Нужно ли вообще определять это понятие? Вопрос не праздный, поскольку многие ученые придерживаются мнения о том, что "информация есть информация и ничто другое и этого достаточно". Действительно, до недавнего времени слово "информация" использовалось в обыденной жизни и в практических задачах (шифровка, связь и т.д.). Там было достаточно понимания о чем идет речь на интуитивном или сугубо прикладном уровне. В последнее время стало ясно, что информация играет в науке фундаментальную роль. Возникла потребность понять, что же это такое? Попытки связать информацию с привычными понятиями материя или энергия успехом не увенчались. Стало ясно, "информация есть информация, а не материя и не энергия". (Н. Винер [1]). Отрицание не может претендовать на роль определения, вместе с тем в данном случае оно существенно, ибо указывает на отсутствие вещественного (и/или полевого) происхождения информации. Попытки связать информацию с энтропией тоже оказались безуспешными, хотя они продолжаются до сих пор (подробнее мы это вопрос обсудим позже). Поэтому вопрос об определении понятия "информация" остается открытым. В книге И.В. Мелик-Гайказян [2] собрана коллекция определений слова "информация", которая обсуждалась в [3], ниже мы будем следовать этим работам.

1.1 Определения понятия "информация

" информация есть знания, переданные кем-то другим или приобретенные путем собственного исследования или изучения" [4];· "информация - это сведения, содержащиеся в данном сообщении и рассматриваемые как объект передачи, хранения и обработки" [5];

" информация в обыденном смысле - это сведения, известия, в научно-технических приложениях - то, что имеет на себе сигнал" [6]. Наряду с этими и подобными им определениями заметна тенденция связывать информацию со степенью упорядоченности той системы, которая получает информацию:

" информация означает порядок, коммуникация есть создание порядка из беспорядка или по крайней мере увеличение степени той упорядоченности, которая существовала до получения сообщения" [7].

Приводимые ниже определения в известной мере повторяются.

" информация - это обозначение содержания, полученного из внешнего мира в процессе нашего приспособления к нему и приспособления к нему наших чувств" [8];

" информация...- одно из свойств предметов, явлений, процессов объективной действительности, созданных человеком управляющих машин, заключающееся в способности воспринимать внутреннее состояние и воздействие окружающей среды и сохранять определенное время результаты его; передавать сведения о внутреннем состоянии и накопленные данные другим предметам, явлениям и процессам" [9];

" информация - объективное содержание связи между взаимодействующими материальными объектами, проявляющееся в изменении состояний этих объектов" [10];

"информация есть текущие данные о переменных величинах в некоей области деятельности, систематизированные сведения относительно основных причинных связей, которые содержатся в знании как понятии более общего класса, по отношению к которому информация является подчиненной" [4];

"информация есть знание о каком-то особом событии, случае или о чем-либо подобном" [4];·

" информацией являются все те данные о внешнем мире, которые мы получаем как путем непосредственного воздействия на наши органы чувств окружающих предметов и явлений, так и опосредованным путем через книги, газеты, рассказы других людей" [11];

" информацией называется всякое сообщение или передача сведений о чем-либо, что заранее не было известно" [12].

У философов популярны дефиниции, содержащие термин "отражение":

" информация в самом общем случае - это разнообразие, которое один объект содержит о другом, это взаимное, относительное разнообразие. С позиций теории отражения информация может быть представлена как отраженное разнообразие, как разнообразие, которое отражающий объект содержит об отраженном" [13];

" информация есть отражение в сознании людей объективных причинно-следственных связей в окружающем нас реальном мире" [14];

" информация - это содержание процессов отражения" [15];

" информация не тождественна отражению, а есть лишь его инвариантная часть, поддающаяся определению, объективированию, передаче" [16].

" информация - это философская категория, рассматриваемая наряду с такими, как пространство, время, материя. В самом общем виде информацию можно представить как сообщение, т.е. форму связи между источником, передающим сообщение и приемником, его принимающим" [17].

Определения такого типа можно обобщить в виде утверждения:

" информация есть отражение отображения наших соображений".

Такого определения в литературе нет. По стилю оно соответствует творениям Кузьмы Пруткова (например, его миниатюре "Спор древнегреческих ученых о прекрасном"). Тем не менее, по глубине и смыслу (если кто-либо попытается его в нем найти), оно не уступает приведенным выше. В философском энциклопедическом словаре (1983 г.) приведено:

" Информация (от лат. informatio - ознакомление, разъяснение, представление, понятие) 1) сообщение, осведомление о положении дел, сведения о чем-либо, передаваемые людьми; 2) уменьшаемая, снимаемая неопределенность в результате получения сообщений; 3) сообщение, неразрывно связанное с управлением, сигналы в единстве синтаксических, семантических и прагматических характеристик; 4) передача, отражение разнообразия в любых объектах и процессах (неживой и живой природы)" [18].

В "Философской энциклопедии (1970 г.) во втором томе читаем: " Информация (от латинского informatio - осведомление) - см. «Теория информации» [19]. А в пятом томе в статье "Теория информации" вместо дефиниций приводятся различные представления о количественной оценке информации. Дефиниции того, что собственно значит термин "информация" просто не дается. Аналогичная ситуация с перекрестными ссылками в энциклопедии описана польским сатириком Станиславом Леммом по поводу определения понятия "сепульки".

В связи с трудностями философского определения понятия "информация" возникло убеждение в том, что оно не может быть отнесено к разряду философских категорий с заменой ею отражения (П. Копнин, [20]).

Особое место в коллекции определений занимают утверждения о том, что информация - это алгоритм:

" информация... есть план строения клетки и, следовательно, всего организма" [21]. Модификация этого определения содержится в работе Э. Янча, трактовавшего информацию как "инструкцию" к самоорганизации в процессе эволюции биологических структур [22].

В работе В. Корогодина [23] приводятся определения:· " информация есть некий алгоритм " "совокупность приемов, правил или сведений, необходимых для построения оператора, будем называть информацией". Под словом "оператор" здесь понимается некое стороннее воздействие на систему, изменяющее спонтанный ход событий. Большое число похожих и непохожих друг на друга определений понятия "информация" означает, что общепринятого определения ещё нет. Более того, нет даже четкого понимания сути этого явления, хотя потребность в нем уже назрела. Сейчас область применимости информационного подхода существенно расширилась. Понятие "информация" используется при исследовании практически всех процессов самоорганизации (в частности биологической эволюции). При этом актуальным становится вопрос о возникновении информации и эволюции её ценности и здесь без определения понятий уже не обойтись. Выбор определения зависит от аппарата исследования, иными словами, определение должно быть конструктивным, то есть пригодным для использования в рамках аппарата. Мы будем использовать аппарат теории динамических систем, поскольку именно он лежит в основе науки о самоорганизации (то есть синергетики). Этим условиям в наибольшей степени удовлетворяет определение информации, предложенное Генри Кастлером [24].

Информация есть случайный и запомненный выбор одного варианта из нескольких возможных и равноправных.

Здесь слово "случайный" выделено, поскольку оно относится к процессу (способу) выбора и потому сужает область применимости определения. Вообще говоря, выбор может быть и не случайным (подсказанным), в этом случае говорят о рецепции информации. Случайный выбор соответствует генерации (то есть спонтанному возникновению) информации. Поэтому слово "случайный" мы в определении информации опустим, но учтем его при обсуждении процессов генерации и рецепции.

Слово "запомненный" тоже выделено, поскольку в дальнейшем будет играть очень важную роль. Оно относится к фиксации информации. Вообще говоря, выбор может и не запоминаться (то есть тут же забываться). Такой выбор будем называть микроинформацией. Запомненный выбор (в отличие от незапоминаемого) будем называть макроинформацией. Во всех информационных процессах используется макроинформация (запоминаемая). Микроинформация используется главным образом в теор-физических спекуляциях по поводу "демона Максвелла" (о чем пойдет речь позже). Поэтому далее под информацией мы будем понимать только запоминаемую информацию и приставку "макро" опустим. Слова "возможных и равноправных" означают, что варианты выбора принадлежат одному множеству и априорные различия между ними не велики. В идеале варианты могут быть полностью равноправны и равновероятны, но могут и отличаться. В этом случае слово "равноправные" означает, что априорные вероятности различных выборов - величины одного порядка. С учетом сказанного примем определение информации в виде:

Информация есть запомненный выбор одного варианта из нескольких возможных и равноправных. (Q)

(G. Quastler)

Будем использовать это определение и ссылаться на него как на дефиницию (Q).

Определение (Q) отличается от предыдущих в следующем. Во-первых оно четко, понятно и широко используется в естественных науках. Конструктивность его проверена на многих примерах [25-28]. Это определение не противоречит предыдущим, когда речь идет о реальных задачах. Так, определение информации как инструкции или оператора в конкретных случаях сводится к указанию, какой именно выбор следует сделать в том или ином случае. Во-вторых согласно этому определению информация предстаёт как нечто конкретное и "приземленное", ощущение чего-то "сверхестественного и романтического в нем отсутствует, исчезает ореол "божественного". Можно считать это недостатком определения, поскольку именно это ощущение привлекает многих людей и вдохновляет их на подвиги (научные, не научные и лже-научные). Тем не менее, мы надеемся показать, что именно это определение позволяет понять такие тонкие явления как возникновение жизни и механизмы мышления с естественно-научной точки зрения. Иными словами - построить мост между естественными науками и гуманитарными. В-третьих определение (Q) допускает введение меры - количества информации.

Подчеркнем еще одну особенность определения (Q). Слово "выбор" - отглагольное существительное. Его можно понимать в двух смыслах: как процесс и как результат процесса. Разница примерно такая же, как между судопроизводством и приговором суда. В определении Кастлера выбор понимается, как результат процесса, но не как сам процесс. Именно в этом смысле (то есть как "приговор") оно конструктивно и именно в этом смысле оно используется в реальных задачах. Слово "процесс" в естественных науках прочно занято, оно означает изменение системы во времени (то есть "движение" её), которое в общем случае ещё не известно чем кончится и кончится ли вообще. Согласно определению (Q) при этом информация еще отсутствует. Однако, информация как результат выбора не мыслима без процесса выбора, как приговор не мыслим без суда. Отнюдь не любой процесс заканчивается выбором, Последнее возможно лишь в процессах определенного класса. Поэтому целесообразно ввести понятие "Информационный процесс", свойства которого мы обсудим позже.

В заключение этого раздела отметим, что в реальных задачах, как правило, фигурирует не просто информация, а ценная или осмысленная информация (пока мы употребляем эти термины, апеллируя к интуиции, определим их позже). Часто это упускают из внимания, полагая, что не ценная информация - вообще не информация. Последнее ведет к недоразумениям.

Количество информации

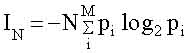

Эта величина была введена в 1948 году Клодом Шенноном [29] на примере текстового сообщения. Количество информации в сообщении, содержащем N символов IN, по Шеннону равно;

(1.1)

где M - число букв в алфавите, pi - частота встречаемости i- ой буквы в языке, на котором написано сообщение, знак " - " перед всей правой частью формулы (1.2) поставлен для того, чтобы Ii была положительной, несмотря на то, что log2 pi < 0 (pi < 1). Двоичные логарифмы выбраны для удобства. При однократном бросании монеты М =2 ("орел" или "решка"), N = 1 и pi =1/2. При этом получаем минимальное количеств информации (I =1), которое называется "бит". Иногда в (1.1) используются натуральные логарифмы. Тогда единица информации называется "нат" и связана с битом соотношением: 1 бит = 1,44 ната. Приведенные формулы позволили определять пропускную способность каналов связи, что послужило основанием для улучшения методов кодирования и декодирования сообщений, выбора помехоустойчивых кодов, словом, для разработки основ теории связи. В этом примере текст можно рассматривать как результат выбора определенного варианта расстановки букв. В общем случае, когда делается выбор одного варианта из n возможных (реализующихся с априорной вероятностью pi: i =1,2,..., n), количество информации выражается формулой:

i=1,2,... n.

i=1,2,... n.

(1.2)

Если все варианты равновероятны, то есть pi =1/n, то:

I= log2 n.

В частном случае сообщения из N букв из бинарного алфавита (М =2) число вариантов равно: n = 2N, количество информации I= N, что совпадает с формулой (1.1). На этом примере удобно пояснить, что означает слово "равноправные" в определении (Q). Представим, что в тексте имеются символы, которые в алфавите вообще не содержатся (не "буквы"). Априорная вероятность такового считается очень малой (pn+1 << 1/n) и в сумме (1,2) не учитывается, поскольку он выпадает из рассматриваемого множества. Отметим, что формула (1.2) отражает количество информации, но не ценность её. Поясним это на примере. Количество информации в сообщении, определяемое формулой Шеннона, не зависит от того или иного сочетания букв: можно сделать сообщение бессмысленным, переставив буквы. В этом случае ценность информации исчезнет, а количество информации останется прежним. Из этого примера следует, что подменять определение информации (с учетом всех её качеств) определением количества информации нельзя. Исторически сложилось так, что определение количества информации было предложено раньше, чем определение самой информации. Для решения ряда практических задач это было полезно. Однако, в дальнейшем подмена понятий часто приводила к недоразумениям. Обсудим в связи с количеством информации ещё два понятия: "Информационная тара" (термин введен В.И. Корогодиным [23]) и "Информационная ёмкость". Первый связан с мощностью множества, из которого выбираются варианты. Второй используется для физических систем, способных хранить информацию. По смыслу они близки друг другу. Поясним смысл их на примере текста. Если любое сочетание букв в тексте является ценным, количество ценной информации совпадает с полным количеством, но не может превышать его. Это значит, что любая передача сигналов и/или запоминающее устройство может содержать какое-то количество ценной (или осмысленной) информации (не больше, чем (1.2) но может содержать и меньшее или не содержать вовсе. В этой связи количество информации в (1.2) можно назвать информационной тарой. Это понятие играет существенную роль при рецепции информации и/или при обработке её (в частности при перекодировке).

Приведем пример. Имеется текст на русском языке, содержащий Nr букв кирилицы (алфавит содержит 32 буквы). Перевод его на английский содержит Na букв латинского алфавита (26 букв). Русский текст - результат выбора определенного варианта из Nr возможных (число вариантов порядка 32 в степени Nr). Английский перевод - выбор определенного расположения латинских букв, который предопределен русским текстом (рецепция информации). Число вариантов в английском текста порядка 26 в степени Na . Количество ценной информации одинаково (если смысл не искажен), а количество информации различно. Ниже, на примерах мы увидим, что процессы генерации, рецепции и обработки ценной информации сопровождаются "переливанием" информации из одной тары в другую. При этом, как правило. количество информации уменьшается, но количество ценной информации сохраняется. Иногда "информационные тары" столь различны. что можно говорить об информациях разного типа. Этот термин мы также будем применять к информациям, имеющим одинаковый смысл и ценность, но сильно различающихся количественно, то есть помещенных в разные тары. В заключение раздела отметим, что сам Шеннон не разделял понятия информация и количество информации, хотя и чувствовал. что это к добру не приведет. "Очень редко, - писал Шеннон, - удается открыть одновременно несколько тайн природы одним и тем же ключом. Здание нашего несколько искусственно созданного благополучия слишком легко может рухнуть, как только в один прекрасный день окажется, что при помощи нескольких магических слов, таких как информация, энтропия, избыточность... нельзя решить всех нерешенных проблем"[29].