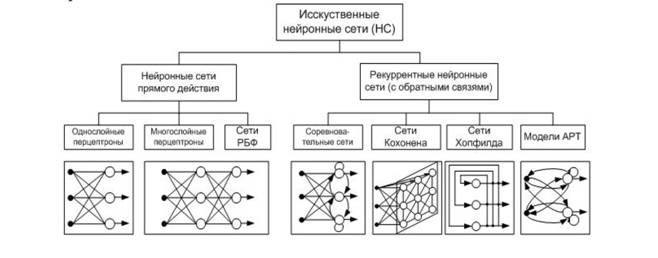

Различные способы объединения нейронов между собой и организации их взаимодействия привели к созданию сетей разных типов. Каждый тип сети, в свою очередь, тесно связан с соответствующим методом подбора весов межнейронных связей (т.е. обучения).

Среди множества существующих видов сетей в качестве важнейших можно выделить однослойный и многослойный персептрон, радиальные сети, сети с самоорганизацией в результате конкуренции нейронов, сети с самоорганизацией корреляционного типа, а также рекуррентные сети, в которых имеются сигналы обратной связи. Отдельно от всех названных типов отстоят нечеткие нейронные сети, функционирование которых основано на принципах нечеткой логики. Ниже приведена схема, объединяющая основные типы искусственных нейросетей.

Рисунок 8 – Обобщенная классификация нейронных сетей

Интересным представляется объединение различных видов нейронных сетей между собой, особенно сетей с самоорганизацией и обучаемых с учителем. Такие комбинации получили название «гибридные сети». Первый компонент – это сеть с самоорганизацией на основе конкуренции, функционирующая на множестве входных сигналов и группирующая их в кластеры по признакам совпадения свойств. Она играет роль препроцессора данных. Второй компонент – в виде сети, обучаемой с учителем (например, персептронной), сопоставляет входным сигналам, отнесенным к конкретным кластерам, соответствующие им заданные значения (постпроцессинг). Подобная сетевая структура позволяет разделить фазу обучения на две части: вначале тренируется компонент с самоорганизацией, а потом – сеть с учителем. Дополнительное достоинство такого подхода заключается в снижении вычислительной сложности процесса обучения, а также в лучшей интерпретации получаемых результатов.

Однослойная нейронная сеть

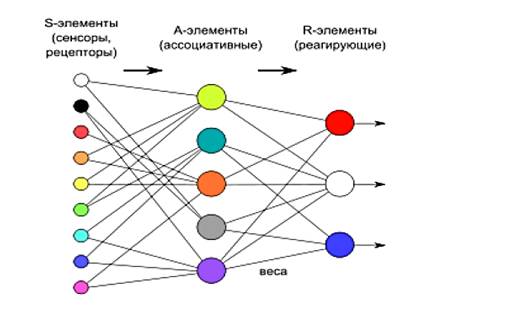

Перцептрон, или персептрон – кибернетическая модель биологического нейрона, предложенная в 1957 году Ф. Розенблаттом и реализованная в виде электронной машины Марк-1 в 1960 году. Персептрон, таким образом, стал одной из первых моделей нейросети, а «Марк-1» – первым в мире нейрокомпьютером. Несмотря на свою простоту, перцептрон имеет способность к самообучению и может решать довольно сложные задачи. Основная математическая задача, с которой он справляется, – это линейное разделение любых нелинейных множеств.

Персептрон состоит из трёх типов элементов: поступающие от сенсоров сигналы передаются ассоциативным элементам, а затем реагирующим элементам. Так, персептроны позволяют создать набор «ассоциаций» или связей между входными сигналами и ожидаемой реакцией на выходе. Согласно современной классификации, персептроны могут быть отнесены к нейронным сетям с одним скрытым слоем; с пороговой передаточной функцией; с прямым распространением сигнала. Хотя один нейрон и способен выполнять простейшие процедуры распознавания, сила нейронных вычислений проистекает от соединений нейронов в сетях.

Рисунок 9 – Структура персептрона с тремя выходами

Отметим, что вершины – круги слева служат лишь для распределения входных сигналов. Они не выполняют каких- либо вычислений, и поэтому не будут считаться слоем. По этой причине они обозначены кругами, чтобы отличать их от вычисляющих нейронов, обозначенных квадратами. Каждый элемент из множества входов Х со своим весом соединен с каждым искусственным нейроном. А каждый нейрон выдает взвешенную сумму входов в сеть. В искусственных и биологических сетях многие соединения могут отсутствовать, все соединения показаны в целях общности.

Могут иметь место также соединения между выходами и входами элементов в слое. Удобно считать веса элементами матрицы W. Матрица имеет т строк и п столбцов, где m – число входов, а n – число нейронов. Например, w2,3 – это вес, связывающий третий вход со вторым нейроном. Таким образом, вычисление выходного вектора N, компонентами которого являются выходы Y нейронов, сводится к матричному умножению N = XW, где N и Х – векторы-строки.

Многослойные нейронные сети

Более крупные и сложные нейронные сети обладают, как правило, и большими вычислительными возможностями. Хотя созданы сети всех конфигураций, какие только можно себе представить, послойная организация нейронов копирует слоистые структуры определенных отделов мозга. Такие многослойные сети обладают большими возможностями, чем однослойные, и в последние годы были разработаны алгоритмы для их обучения. Многослойные сети могут образовываться каскадами слоев; выход одного слоя является входом для последующего слоя.Многослойные сети не могут привести к увеличению вычислительной мощности по сравнению с однослойной сетью лишь в том случае, если активационная функция между слоями будет нелинейной. Вычисление выхода слоя заключается в умножении входного вектора на первую весовую матрицу с последующим умножением (если отсутствует нелинейная активационная функция) результирующего вектора на вторую весовую матрицу (XW1)W2. Так как умножение матриц ассоциативно, то X(W1W2).

Сети РБФ (сети с радиальными базисными функциями)

Нейронная сеть радиальных базисных функций содержит в наиболее простой форме три слоя: обычный входной слой, выполняющий распределение данных образца для первого слоя весов; слой скрытых нейронов с радиально симметричной активационной функцией, выходной слой.

Для построения сети РБФ необходимо выполнение следующих условий:

1) наличие эталонов, представленных в виде весовых векторов нейронов скрытого слоя;

2) наличие способа измерения расстояния входного вектора от эталона. Обычно это стандартное евклидово расстояние;

3) специальная функция активации нейронов скрытого слоя, задающая выбранный способ измерения расстояния. Обычно используется функция 16 Гаусса, которая существенно усиливает малую разницу между входным и эталонным векторами.

Нейронные сети, построенные на РБФ, имеют ряд преимуществ перед рассмотренными многослойными сетями прямого распространения. Во-первых, они моделируют произвольную нелинейную функцию с помощью всего одного промежуточного слоя, тем самым избавляя разработчика от необходимости решать вопрос о числе слоев. Во-вторых, параметры линейной комбинации в выходном слое можно полностью оптимизировать с помощью известных методов линейной оптимизации, которые работают быстро и не испытывают трудностей с локальными минимумами, мешающими при обучении с использованием алгоритма обратного распространения ошибки. Поэтому сеть РБФ обучается очень быстро – на порядок быстрее, чем с использованием алгоритма ОР (обратного распространения). Недостатки сетей РБФ: данные сети обладают плохими экстраполирующими свойствами и получаются весьма громоздкими при большой размерности вектора входов.

Сети с обратными связями

У сетей, рассмотренных до сих пор, не было обратных связей, т.е. соединений, идущих от выходов некоторого слоя к входам этого же слоя или предшествующих слоев. Этот специальный класс сетей, называемых сетями без обратных связей или сетями прямого распространения, представляет практический интерес и широко используется. Сети более общего вида, имеющие соединения от выходов к входам, называются сетями с обратными связями. У сетей без обратных связей нет памяти, их выход полностью определяется текущими входами и значениями весов. В некоторых конфигурациях сетей с обратными связями предыдущие значения выходов возвращаются на входы выход, следовательно, определяется как текущим входом, так и предыдущими выходами.

Сеть Кохонена

Сеть Кохонена еще называют «самоорганизующейся картой признаков». Сеть такого типа рассчитана на самостоятельное обучение, во время обучения сообщать ей правильные ответы необязательно. В процессе обучения на вход сети подаются различные образцы. Сеть улавливает особенности их структуры и разделяет образцы на кластеры, а уже обученная сеть относит каждый вновь поступающий пример к одному из кластеров, руководствуясь некоторым критерием «близости».

Сеть Хопфилда

Сеть Хопфилда использует три слоя: входной, слой Хопфилда и выходной слой. Каждый слой имеет одинаковое количество нейронов. Входы слоя Хопфилда подсоединены к выходам соответствующих нейронов входного слоя через изменяющиеся веса соединений. Выходы слоя Хопфилда подсоединяются ко входам всех нейронов слоя Хопфилда, за исключением самого себя, а также к соответствующим элементам в выходном слое.

НейронныесетиАРТ (adaptive resonance theory (ART))

В большинстве нейронных сетей, обучаемых методом обратного распространения, генетическими алгоритмами, в двунаправленной ассоциативной памяти, сетях Хопфилда и т.д. очень часто обучение новому образу, ситуации или ассоциации заметно искажает или даже уничтожает плоды предшествующего обучения, требуя изменения значительной части весов связей или полного переобучения сети. В этом отношении указанные 20 нейронные сети резко отличаются от мозга человека, который, непрерывно обрабатывая потоки информации из внешней среды, может как модифицировать и уточнять хранящиеся в памяти образы, так и создавать новые, не уничтожая то, что уже хранится. Таким образом, мозг человека обладает высокой пластичностью к поступающей информации, позволяющей ему воспринимать новые образы и уточнять хранящуюся информацию по уже известным, и в то же время он имеет и высокую стабильность, сохраняя ранее полученные знания.

Невозможность с помощью уже известных нейронных сетей решить проблему стабильности – пластичности явилась одной из основных причин разработки принципиально новых конфигураций нейросетей. Примером таких сетей являются нейросети, полученные на основе адаптивной резонансной теории, разработанной Гроссбергом и Карпентером. Эти сети в известной мере позволяют решать противоречивые задачи чувствительности к новым данным и сохранения полученных знаний.

Нейронная сеть адаптивной резонансной теории (АРТ) относит входное изображение к одному из известных классов, если оно в достаточной степени подобно или резонирует с прототипом этого класса. Если найденный прототип с определенной точностью, задаваемой специальным параметром сходства, соответствует входному изображению, то он модифицируется, чтобы стать более похожим на предъявленное изображение. Когда входное изображение недостаточно подобно ни одному из имеющихся прототипов, то на его основе создается новый класс. Это возможно благодаря тому, что сеть имеет большое число избыточных или нераспределенных элементов, которые не используются до тех пор, пока в этом нет необходимости (если нет нераспределенных нейронов, то входное изображение не вызывает реакции сети). Таким образом, новые образы могут создавать новые классы, но не могут исказить существующую память.

РАСЧЕТНАЯ ЧАСТЬ

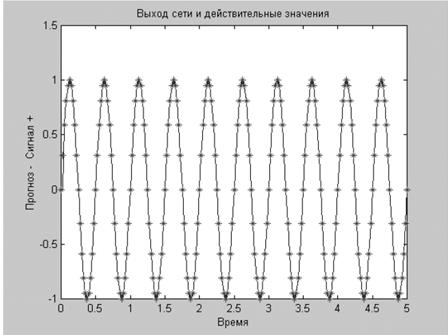

Пусть имеется функция времени, описываемая соотношением x(t) = sin(4πt), причем сигнал – дискретный с интервалом 0,025 с.

Построим линейную нейронную сеть, позволяющую восстанавливать значение подобного сигнала по 5 предыдущим. Вариант решения данной задачи приведен ниже.

» t = 0:0.025:5; % Задание диапазона времени от 0 до 5 секунд

»х = sin(t*4*pi); % Предсказываемый сигнал

» Q = length(x);

» % Создание входных векторов

» Р = zeros(5,Q); % Создание нулевой матрицы Р

» Р(1,2:Q) = х(1,1:(Q-1));

» P(2,3:Q) = х(1,1:(Q-2)):

» P(3, 4:Q) = x(l, l:(Q-3));

» P(4,5:Q) = x(l,l:(Q-4));

» P(5,6:Q) = x(l,1:(Q-5));

» s = newlind(P,x); % Создание новой НС с именем s

» у = sim(s,P); % Расчет восстанавливаемых значений

» % Вывод графиков исходного сигнала и требуемых значений

» plot(t,y,t,x,'*');

» xlabel('Время');

» ylabel(' Восстановление - Сигнал +');

» title('Выход сети и действительные значения');

» % Расчет и создание графика ошибки восстановления

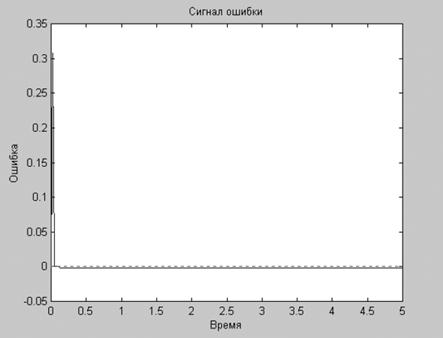

» е = х - у;

» plot(t,e);

» hold on;

» plot([min(t) max(t)], [0 0], ':г');

» hold off;

» xlabel('Время');

» уlabel('Ошибка');

» title('Сигнал ошибки');

В данном случае сеть была построена с помощью функции newlind, при использовании которой не требуется дополнительного обучения.

Рисунок 10 – Исходный сигнал и восстановление

Рисунок 11– Ошибка восстановления

Судя по графикам результатов, приведенным на рисунке 10 и 11, точность восстановления с использованием линейной НС является достаточно хорошей.

Заключение

Искусственные нейронные сети предложены для задач, простирающихся от управления боем до присмотра за ребенком. Потенциальными приложениями являются те, где человеческий интеллект малоэффективен, а обычные вычисления трудоемки или неадекватны. Этот класс приложений во всяком случае не меньше класса, обслуживаемого обычными вычислениями, и можно предполагать, что искусственные нейронные сети займут свое место наряду с обычными вычислениями в качестве дополнения такого же объема и важности.

Это возрождение интереса было вызвано как теоретическими, так и прикладными достижениями. Неожиданно открылись возможности использования вычислений в сферах, до этого относящихся лишь к области человеческого интеллекта, возможности создания машин, способность которых учиться и запоминать удивительным образом напоминает мыслительные процессы человека.

Было разработано множество обучающих алгоритмов, каждый со своими сильными и слабыми сторонами. Все еще существуют проблемы относительно того, чему сеть может обучиться и как обучение должно проводиться.

В данной курсовой работе была реализована задача разработки и исследование нейронной сети в среде «MatLab», для восстановления ненаблюдаемых координат пространства состояний объекта.

Список используемой литературы

1) Горшкова К.Л. Искусственные нейронные сети и нечеткая логика в задачах контроля и управления.Методические указания по выполнению курсовой работы. /К.Л. Горшкова – Альметьевск 2016. – 12 с.

2) Ануфриев И.Е. MATLAB 7. Наиболее полное руководство в подлиннике. / И.Е. Ануфриев, А.Б. Смирнов, Е.Н. Смирнова. – СПб.: БХВ-Петербург, 2005. – 1104 с.

3) Комарцова Л.Г. Нейрокомпьютеры: учебное пособие для вузов. – 2-е изд. / Л.Г. Комарцова, А.В. Максимов. – Изд-во МГТУ им. Н.Э. Баумана, 2004. – 400 с.

4) Медведев В.С. Нейронные сети. MATLAB 6 / В.С. Медведев, В.Г. Потемкин. – М.: ДИАЛОГ-МИФИ, 2002. – 496 с.

5) Уоссермен Ф. Нейрокомпьютерная техника: теория и практика. / Ф. Уоссермен. – М.: Мир, 1992. – 118 с.

6) Ясницкий Л.Н. Искусственный интеллект. Элективный курс: учебное пособие / Л.Н. Ясницкий. – М.: БИНОМ, Лаборатория знаний, 2011. – 200 с.

7) Усков А.А., Кузьмин А.В. Интеллектуальные технологии управления. Искусственные нейронные сети и нечеткая логика. М.: Горячая линия - Телеком, 2004. – 143 с.

8) Дьяконов В.П., Круглов В.В. MATLAB 6.5 SP1/7/7 SP1/7 SP2 + Simulink 5/6. Инструменты искусственного интеллекта и биоинформатики. – М.: СОЛОН-ПРЕСС, 2006. – 456 с.

9) Гостев В.И. Проектирование нечетких регуляторов для систем автоматического управления. – СПб.: БХВ-Петербург, 2011. – 416с.

10) Дьяконов В., Круглов В. Математические пакеты расширения MATLAB: специальный справочник. – СПб.: Питер, 2001. – 480 с.