ВВЕДЕНИЕ

Цель данной контрольной работы - актуализация знаний в предмете «Основы теории информации».

В рамках контрольной работы было выполнено 5 заданий в соответствии с моим вариантом (вариант №23):

. Определить среднее количество информации, содержащееся в сообщении, используемом три независимых символа S1, S2, S3. Известны вероятности появления символов p(S1)=p1, p(S2)=p2, p(S3)=p3. Оценить избыточность сообщения.

. В условии предыдущей задачи учесть зависимость между символами, которая задана матрицей условных вероятностей P(Si / Sj).

. Провести кодирование по одной и блоками по две буквы, используя метод Шеннона - Фано. Сравнить эффективности кодов (величина энтропии). Данные взять из задачи 1.

. Алфавит передаваемых сообщений состоит из независимых букв Si. Вероятности появления каждой буквы в сообщении заданы. Определить и сравнить эффективность кодирования сообщений методом Хаффмана при побуквенном кодировании и при кодировании блоками по две буквы.

. Определить пропускную способность канала связи, по которому передаются сигналы Si. Помехи в канале определяются матрицей условных вероятностей P(Si / Sj). За секунду может быть передано N = 10 сигналов.

Простые вычисления и кодирования сообщений в заданиях были сделаны вручную, более сложные были сделаны с помощью среды разработки MATLAB R2014a. Формулы и решения задач были введены с помощью программы MathType.

.

ОПРЕДЕЛЕНИЕ СРЕДНЕГО КОЛИЧЕСТВА ИНФОРМАЦИИ

Энтропия источника - среднее количество информации в одном сообщении. Не следует путать энтропию с количеством информации в одном конкретном сообщении. Если в источнике есть множество сообщений, точно знать о каждом из них необязательно. В этом заключается преимущество среднего значения количества информации. Усреднение позволило Шеннону оценить как редкие, так и частые сообщения. Энтропия характеризует источник сообщения. Аналогично можно получить и “энтропийную характеристику сигнала”.

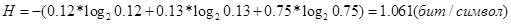

Задание: определить среднее количество информации, содержащееся в сообщении, используемом три независимых символа S1, S2, S3. Известны вероятности появления символов p(S1)=p1, p(S2)=p2, p(S3)=p3. Оценить избыточность сообщения. Вариант №23: p1=0.12; p2=0.13; p3=0.75.

Решение. Максимальное среднее количество информации на символ сообщения имеет место при равновероятном распределении и равно, согласно формуле

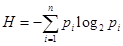

Рассчитаем среднее количество информации на символ сообщения при заданных вероятностях по формуле, где n - число символов в алфавите, p - вероятность появления события.

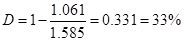

Оценим избыточность сообщения по формуле.

Максимальная энтропия.

Реальная энтропия.

Избыточность сообщения.

ЗАВИСИМОСТЬ МЕЖДУ СИМВОЛАМИ МАТРИЦЫУСЛОВНЫХ ВЕРОЯТНОСТЕЙ

В большинстве реальных случаев появление элемента хi в сообщении зависит от того, какой элемент хj был предшествующим. Взаимосвязь элементов в сообщении характеризуется матрицей условных вероятностей.

Задание: в условии предыдущей задачи учесть зависимость между символами, которая задана матрицей условных вероятностей P(Si / Sj).

Вариант №23.

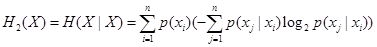

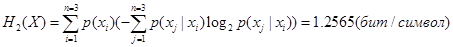

Решение. Рассчитаем энтропию источника по формуле.

Подставим числовые данные, используя задание 1.

Вычисление энтропии в программе MATLAB.

=p1*((0.7*log2(0.7)+0.3*log2(0.3)))+p2*((0.5*log2(0.5)+0.5*log2(0.5))++p3*(-(0.1*log2(0.1)+0.5*log2(0.5)+0.4*log2(0.4)));