ОДп..02.

Информатика и ИКТ

Автомеханик

УРОК № 6

Группа: АМ-3-20

Дата: 08.10.2020 г.

Преподаватель: Л.Н.Иванова

ТЕМА УРОКА: КОЛИЧЕСТВО ИНФОРМАЦИИ КАК МЕРА УМЕНЬШЕНИЯ

НЕОПРЕДЕЛЁННОСТИ ЗНАНИЙ

Цель урока: сформировать понятие количества информации как мера уменьшения

неопределённости знаний

За единицу принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность знаний в два раза. Такая единица называется бит (bit — от английского словосочетания Binary digiT). Следующая по величине единица — байт, 1 байт — это количество информации об одном символе (букве, цифре, знаке).

Уменьшение неопределённости знания.

Подход к информации как к мере уменьшения неопределённости знания позволяет количественно измерять информацию. Пусть у нас имеется монета, которую мы бросаем на ровную поверхность. С равной вероятностью произойдёт одно из двух возможных событий – монета окажется в одном из двух положений: "орёл" или "решка". События равновероятны, если при возрастающем числе опытов число выпадений "орла" и "решки" постепенно сближаются. Перед броском существует неопределённость нашего знания (возможны 2 события), и как упадёт монета – предсказать невозможно. После броска наступает полная определённость, т.к. мы видим, что монета в данный момент находится в определённом положении. Это сообщение приводит к уменьшению неопределённости нашего знания в 2 раза, т.к. из двух возможных равновероятных событий реализовалось одно. В окружающей действительности часто встречаются ситуации, когда может произойти большее, чем 2, число равновероятных событий. Чем больше начальное число возможных равновероятных событий, тем больше начальная неопределённость нашего знания и тем большее количество информации будет содержать сообщение о результатах опыта.

Формула, которая связывает между собой количество возможных событий N и количество информации I:

N=2I

Единица измерения количества информации

За единицу количества информации принято такое количество информации, которое содержит сообщение уменьшающее неопределённость знания в 2 раза. Такая единица названа бит.

Компьютер оперирует числами в двоичной системе счисления, поэтому в кратных единицах измерения количества информации используется коэффициент 2n.

Следующей по величине единицей измерения количества информации является байт, причём

1 байт = 23 бит = 8 бит.

Кратные байту единицы измерения количества информации вводятся следующим образом:

1 Кбайт = 210 байт = 1024 байт

1 Мбайт = 210 Кбайт =1024 Кбайт = 220 байт

1 Гбайт = 210 Мбайт = 1024 Мбайт = 220 Кбайт = 230 байт.

Формулы Хартли и Шеннона

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I = log2 N,

где N - количество равновероятных событий; I - количество бит в сообщении о том, что любое из N событий произошло.

Иногда формулу Хартли записывают так:

I = log2 N = log2 (1 / р) = log2 р-1 = - log2 р,

т. к. каждое из N событий имеет равновероятный исход р = 1 / N, то N = 1 / р.

На первый взгляд, кажется, что получается парадокс: количество информации выражается отрицательным числом. Однако если вспомнить, что вероятность – это величина в диапазоне от 0 до 1, то все становится понятным

Задача.

Бросание монеты.

Количество информации от одного события составляет

I = log2 2 = 1 бит информации.

Задача.

Шарик находится в одной из трех урн: А, В или С. Определить, сколько бит информации содержит сообщение о том, что он находится в урне В.

Решение.

Такое сообщение содержит I = log2 3 = 1,585 бита информации.

Разновероятные события.

Не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричный предмет. Еще один бытовой пример - "правило бутерброда".

"Однажды в детстве я уронил бутерброд. Глядя, как я виновато вытираю масляное пятно, оставшееся на полу, старший брат успокоил меня:

- не горюй, это сработал закон бутерброда.

- Что еще за закон такой? - спросил я.

- Закон, который гласит: "Бутерброд всегда падает маслом вниз". Впрочем, это шутка, - продолжал брат.- Никакого закона нет. Просто бутерброд действительно ведет себя довольно странно: большей частью масло оказывается внизу.

- Давай-ка еще пару раз уроним бутерброд, проверим, - предложил я. - Все равно ведь его придется выкидывать.

Проверили. Из десяти раз восемь бутерброд упал маслом вниз.

И тут я задумался: а можно ли заранее узнать, как сейчас упадет бутерброд маслом вниз или вверх?

Наши опыты прервала мать…"

(Отрывок из книги "Секрет великих полководцев", В.Абчук).

В 1948 г. американский инженер и математик К. Шеннон предложил формулу для вычисления количества информации для событий с различными вероятностями.

Если I - количество информации,

N - количество возможных событий,

рi - вероятности отдельных событий,

то количество информации для событий с различными вероятностями можно определить по формуле:

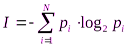

,

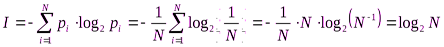

,

где i принимает значения от 1 до N.

Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона:

При равновероятных событиях получаемое количество информации максимально.

Задачи.

1. Определить количество информации, получаемое при реализации одного из событий, если бросают:

а) несимметричную четырехгранную пирамидку;

б) симметричную и однородную четырехгранную пирамидку.

Решение.

а) Будем бросать несимметричную четырехгранную пирамидку.

допустим, что грани пирамидки такие, что отношение их площадей можно представить пропорцией: 4: 2: 1: 1. Тогда, вероятность отдельных событий будет такова:

р1 = 1 / 2,

р2 = 1 / 4,

р3 = 1 / 8,

р4 = 1 / 8,

Вычислим по формуле Шеннона количество информации, получаемой после реализации одного из этих событий:

I = -(1 / 2 log2 1/2 + 1 / 4 log2 1/4 + 1 / 8 log2 1/8 + 1 / 8 log2 1/8) = 1 / 2 + 2 / 4 + + 3 / 8 + 3 / 8 = 14/8 = 1,75 (бит).

б) Теперь рассчитаем количество информации, которое получится при бросании симметричной и однородной четырехгранной пирамидки:

I = log2 4 = 2 (бит).

2. Вероятность перового события составляет 0,5, а второго и третьего 0,25. Какое количество информации мы получим после реализации одного из них?

3. Какое количество информации будет получено при игре в рулетку с 32-мя секторами?

4. Сколько различных чисел можно закодировать с помощью 8 бит?

Решение: I=8 бит, N=2I=28=256 различных чисел.

Физиологи и психологи научились определять количество информации, которое человек может воспринимать при помощи органов чувств, удерживать в памяти и подвергать обработке. Информацию можно представлять в различных формах: звуковой, знаковой и др.

Рассмотренный выше способ определения количества информации, получаемого в сообщениях, которые уменьшают неопределенность наших знаний, рассматривает информацию с позиции ее содержания, новизны и понятности для человека. С этой точки зрения в опыте по бросанию кубика одинаковое количество информации содержится в сообщениях "два", "вверх выпала грань, на которой две точки" и в зрительном образе упавшего кубика.

При передаче и хранении информации с помощью различных технических устройств информацию следует рассматривать как последовательность знаков (цифр, букв, кодов цветов точек изображения), не рассматривая ее содержание.

Считая, что алфавит (набор символов знаковой системы) - это событие, то появление одного из символов в сообщении можно рассматривать как одно из состояний события. Если появление символов равновероятно, то можно рассчитать, сколько бит информации несет каждый символ. Информационная емкость знаков определяется их количеством в алфавите. Чем из большего количества символов состоит алфавит, тем большее количество информации несет один знак. Полное число символов алфавита принято называть мощностью алфавита.

При таком подходе бит – это количество информации, содержащееся в одном дискретном сообщении источника равновероятных сообщений с объемом алфавита равным двум.

Каждая буква русского алфавита (если считать, что е=ё) несет информацию 5 бит (32 = 2I).

Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

Следовательно, слово на русском языке из 5 букв в появившемся тексте (событии) содержит количество информации 5х5 = 25 бит.

При таком подходе в результате сообщения о результате бросания кубика, получим различное количество информации. Чтобы его подсчитать, нужно умножить количество символов на количество информации, которое несет один символ.

ДОМАШНЕЕ ЗАДАНИЕ: написать краткий конспект по теме урока.