МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ

Федеральное государственное автономное образовательное учреждение

Высшего профессионального образования

«Санкт-Петербургский государственный университет аэрокосмического

приборостроения»

Факультет 2

Руководитель Соколовская М.В.

стар. преподаватель

Реферат

на тему: «Понятие информатики и информации»

Работу выполнил

Студент гр. 2516 Петров Д.С.

Санкт-Петербург

СОДЕРЖАНИЕ

I. Понятие информации

| 1.Введение. 2. Понятие информации. 3. Представление информации. 4. Передача информации. 5. Измерение информации. 6. Использование информации. 7. Свойства информации. 8. Обработка информации. 9. Информационные ресурсы и информационные технологии. 10. Информатизация общества. II. Информатика |

11. Понятие информатики 14

12. Назначение информатики 16

13. Литература 19

ВВЕДЕНИЕ.

Существует несколько взглядов на то, что принято считать информацией. Один взгляд, и его, по-видимому, придерживается большая часть специалистов, сводится к тому, что существует как бы два сорта информации:

· Информация техническая, которая передаётся по телеграфным линиям и

отображается на экранах радиолокаторов. Количество такой информации может

быть точно вычислено, и процессы, происходящие с такой информацией,

подчиняются физическим законам.

· Информация семантическая, то есть смысловая. Это та самая информация,

которая содержится, к примеру, в литературном произведении. Для такой

информации предлагаются различные количественные оценки и даже строятся

математические теории. Но общее мнение скорее сводится к тому, что

|

|

оценки здесь весьма условны и приблизительны и алгеброй гармонию всё-таки не

проверишь.

Второй взгляд состоит в том, что информация - это физическая величина, такая

же, как, например, энергия или скорость. Определённым образом и в

определённых условиях информация равным образом описывает как процессы,

происходящие в естественных физических системах, так и процессы в системах,

искусственно созданных.

Как всегда, при наличии двух резко противоположных мнений существует и

третье, примиряющее. Сторонники третьего подхода считают, что информация

едина, но вот количественные оценки должны быть разными.

Отдельно нужно измерять количество информации, причём количество информации - строгая оценка, относительно которой можно развивать единую строгую теорию. Кроме количества информации, следует измерять ещё и ценность. А вот с ценностью информации происходит то же самое, что и с понятием семантической информации. С одной стороны, вроде её можно вычислить, а с другой стороны, все эти вычисления справедливы лишь в ограниченном числе

случаев. И вообще, кто может точно вычислить, скажем, ценность крупного

научного открытия?

Бурное развитие науки и промышленности в XX веке, неудержимый рост объёмов поступающей информации привели к тому, что человек оказался не в состоянии воспринимать и перерабатывать всё ему предназначенное. Возникла необходимость классифицировать поступления по темам, организовывать их хранение, доступ к ним, понять закономерности движения информации в различных изданиях и т.д. Исследования, позволяющие разрешить возникшие проблемы, стали называть информатикой.

|

|

Понятие информации.

Термин "информация" происходит от латинского слова "informatio", что означает

сведения, разъяснения, изложение.

Информация — это настолько общее и глубокое понятие, что его  нельзя объяснить одной фразой. В это слово вкладывается различный смысл в технике, науке и в житейских ситуациях. В обиходе информацией называют любые данные или сведения, которые кого-либо интересуют. Например, сообщение о каких-либо событиях, о чьей-либо деятельности и т.п. "Информировать" в этом смысле означает "сообщить нечто, неизвестное раньше".

нельзя объяснить одной фразой. В это слово вкладывается различный смысл в технике, науке и в житейских ситуациях. В обиходе информацией называют любые данные или сведения, которые кого-либо интересуют. Например, сообщение о каких-либо событиях, о чьей-либо деятельности и т.п. "Информировать" в этом смысле означает "сообщить нечто, неизвестное раньше".

Информация — сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые воспринимают информационные системы (живые организмы, управляющие машины и др.) в процессе жизнедеятельности и работы.

Одно и то же информационное сообщение (статья в газете, объявление, письмо,

телеграмма, справка, рассказ, чертёж, радиопередача и т.п.) может содержать

разное количество информации для разных людей — в зависимости от их

предшествующих знаний, от уровня понимания этого сообщения и интереса к нему.

Так, сообщение, составленное на японском языке, не несёт никакой новой

информации человеку, не знающему этого языка, но может быть

высокоинформативным для человека, владеющего японским. Никакой новой

информации не содержит и сообщение, изложенное на знакомом языке, если его

содержание непонятно или уже известно.

Информация есть характеристика не сообщения, а соотношения между сообщением и его потребителем. Без наличия потребителя, хотя бы потенциального, говорить об информации бессмысленно.

|

|

В случаях, когда говорят об автоматизированной работе с информацией

посредством каких-либо технических устройств, обычно в первую очередь

интересуются не содержанием сообщения, а тем, сколько символов это сообщение

содержит. Применительно к компьютерной обработке данных под информацией понимают некоторую последовательность символических обозначений (букв, цифр, закодированных графических образов и звуков и т.п.), несущую смысловую

нагрузку и представленную в понятном компьютеру виде. Каждый новый символ в такой последовательности символов увеличивает информационный объём сообщения.

Представление информации.

Информация может существовать в самых разнообразных формах:

o в виде текстов, рисунков, чертежей, фотографий;

o в виде световых или звуковых сигналов;

o в виде радиоволн;

o в виде электрических и нервных импульсов;

o в виде магнитных записей;

o в виде жестов и мимики;

o в виде запахов и вкусовых ощущений;

o в виде хромосом, посредством которых передаются по наследству признаки и

свойства организмов и т.д.

Предметы, процессы, явления материального или нематериального свойства,

рассматриваемые с точки зрения их информационных свойств, называются

информационными объектами.

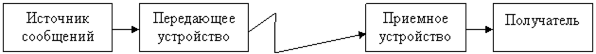

Передача информации.

Всякое событие, всякое явление служит источником информации.

Информация передаётся в виде сообщений от некоторого источника информации к

её приёмнику посредством канала связи между ними. Источник посылает

её приёмнику посредством канала связи между ними. Источник посылает

передаваемое сообщение, которое кодируется в передаваемый сигнал. Этот сигнал

посылается по каналу связи. В результате в приёмнике появляется принимаемый

сигнал, который декодируется и становится принимаемым сообщением. Передача

информации по каналам связи часто сопровождается воздействием помех,

вызывающих искажение и потерю информации.

Любое событие или явление может быть выражено по-разному, разным способом,

разным алфавитом. Чтобы информацию более точно и экономно передать по каналам

связи, ее надо соответственно закодировать.

Информация не может существовать без материального носителя, без передачи

энергии. Закодированное сообщение приобретает вид сигналов-носителей

информации. Они-то и идут по каналу. Выйдя на приемник, сигналы должны

обрести вновь общепонятный вид. С этой целью сигналы пробегают декодирующее устройство, приобретая форму, удобную для абонента. Система связи сработала, цель достигнута. Когда говорят о каналах связи, о системах связи, чаще всего для примера берут телеграф. Но каналы связи - понятие очень широкое, включающее множество всяких систем, самых разных.

Чтобы ясен был многоликий характер понятия “канал связи”, достаточно

привести несколько примеров. При телефонной передаче источник сообщения - говорящий. Кодирующее устройство, изменяющее звуки слов в электрические импульсы, - это микрофон. Канал, по которому передается информация - телефонный провод. Та часть трубки, которую мы подносим к уху, выполняет роль декодирующего устройства. Здесь электрические сигналы снова преобразуются в звуки. И наконец, информация поступает в “принимающее устройство”-ухо человека на другом конце провода. А вот канал связи совершенно другой природы - живой нерв. Здесь все

сообщения передаются нервным импульсом. Но в технических каналах связи

направление передачи информации может меняться, а по нервной системе передача идет в одном направлении.

Еще один пример - вычислительная машина. И здесь те же характерные черты.

Отдельные системы вычислительной машины передают одна другой информацию с

помощью сигналов. Ведь вычислительная машина - автоматическое устройство для обработки информации, как станок - устройство для обработки металла. Машина

не создает из “ничего” информацию, она преобразует только то, что в нее введено.

КАНАЛ СВЯЗИ

| |||

|

Рис.1.Общая схема передачи информации.

.

Измерение информации.

Какое количество информации содержится, к примеру, в тексте романа "Война и

мир", во фресках Рафаэля или в генетическом коде человека? Ответа на эти вопросы наука не даёт и, по всей вероятности, даст не скоро. А возможно ли объективно измерить количество информации? Важнейшим результатом теории информации является вывод:

В определенных, весьма широких условиях можно пренебречь качественными

особенностями информации, выразить её количество числом, а также сравнить

количество информации, содержащейся в различных группах данных.

В настоящее время получили распространение подходы к определению понятия

"количество информации", основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле её новизны или, иначе, уменьшения неопределённости наших знаний об объекте.

Так, американский инженер Р. Хартли (1928 г.) процесс получения информации

рассматривает как выбор одного сообщения из конечного наперёд заданного

множества из N равновероятных сообщений, а количество информации I,

содержащееся в выбранном сообщении, определяет как двоичный логарифм N.

Формула Хартли: I = log2N.

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По

формуле Хартли можно вычислить, какое количество информации для этого

требуется: I = log2100 ” 6,644. То есть сообщение о верно угаданном числе

содержит количество информации, приблизительно равное 6,644 единиц информации.

Приведем другие примеры равновероятных сообщений:

при бросании монеты: "выпала решка", "выпал орел";

на странице книги: "количество букв чётное", "количество букв нечётное".

Определим теперь, являются ли равновероятными сообщения "первой выйдет из

дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно

ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г.

другую формулу определения количества информации, учитывающую возможную

неодинаковую вероятность сообщений в наборе.

Формула Шеннона: I = – (p1 log2 p1 + p2 log2 p2 +... + pN log2 pN),

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N

сообщений.

Легко заметить, что если вероятности p1,..., pN равны, то каждая из них

равна 1/N, и формула Шеннона превращается в формулу Хартли.

равна 1/N, и формула Шеннона превращается в формулу Хартли.

Помимо двух рассмотренных подходов к определению количества информации,

существуют и другие. Важно помнить, что любые теоретические результаты применимы лишь к определённому кругу случаев, очерченному первоначальными

допущениями.

В качестве единицы информации условились принять один бит (англ. bit —

binary, digit — двоичная цифра).Бит в теории информации — количество информации, необходимое для различения двух равновероятных сообщений.

А в вычислительной технике битом называют наименьшую "порцию" памяти,

необходимую для хранения одного из двух знаков "0" и "1", используемых для

внутримашинного представления данных и команд.

Бит — слишком мелкая единица измерения. На практике чаще применяется более

крупная единица — байт, равная восьми битам. Именно восемь битов требуется

для того, чтобы закодировать любой из 256 символов алфавита клавиатуры

компьютера (256=28).

Широко используются также ещё более крупные производные единицы информации:

Ø 1 Килобайт (Кбайт) = 1024 байт = 210 байт,

Ø 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт,

Ø 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт.

В последнее время в связи с увеличением объёмов обрабатываемой информации

входят в употребление такие производные единицы, как:

Ø 1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт,

Ø 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт.

За единицу информации можно было бы выбрать количество информации,

необходимое для различения, например, десяти равновероятных сообщений. Это

будет не двоичная (бит), а десятичная (дит) единица информации.