Модель системы связи.

Модель сложных систем связи источников и получателей представляют в виде блочной структуры. Примером такой блочной структуры служит модель системы связи приведённая в работе Шеннона.

Здесь КПД – канал передачи данных. Под сообщением понимается форма представления информации. Одна и та же информация может быть представлена различными сообщениями, т.е. в различной форме. Под сигналом понимается материальный переносчик сообщений.

структура передающего терминала:

увв – устройство чтения информации с различного рада носителей (клавиатура, сканер, CD-ROM). КОДЕР в общем случае выполняет две основные функции: устранение вредной избыточности из сообщений, т.е. данных не несущих полезной информации (оптимальное или эффективное кодирование); введение полезной избыточности, т.е. таких дополнительных данных, которые позволяют обнаруживать и исправлять возможные ошибки в процессе передачи сообщений по ЛС (помехоустойчивое кодирование).

МОДУЛЯТОР служит для уплотнения ЛС и для согласования свойств сигнала с параметрами ЛС.

Структура приемного терминала. В нем выполняются операции обратные тем, которые выполняются в передающем терминале.

ДЕМОДУЛЯТОР выполняет функции детектирования принимаемого сообщения (функция обратная функции модуляции).

ДЕКОДЕР в общем случае выполняет так же две функции: восстановление исходного сообщения в вид, пригодный для получателя; решается задача оптимального приема, т.е. принимаемое сообщение обрабатывается с учетом априорных сведений о сообщении и о помехе (это позволяет обеспечить наиболее высокую степень достоверности принятого сообщения).

УВВ – это любое устройство для регистрации сообщения на одном из накопителей.

При реализации ПД и Д режимов работы абоненты снабжаются приемо-передающими терминалами, т.е. такие устройства могут выполнять функции как приемных, так и передающих терминалов.

структура приемо-передающего терминала

В ППТ модулятор и демодулятор выполняются в виде одного конструктивного устройства – модема. Кодирующее и декодирующее устройства оформляются также в одном конструктиве – кодеке.

КОДЕК = КОДЕР + ДЕКОДЕР

МОДЕМ = МОДУЛЯТОР + ДЕМОДУЛЯТОР

Таким образом можно сделать следующие выводы:

Понятие информации связано с некоторыми моделями реальных вещей, отражающими их сущность в той или иной степени, в какой это необходимо для практических целей.

В любых средствах отображения: информация представляется информационной моделью – организованной в соответствии с определенной системой правил отображения, состоящей из объекта управления, внешней среды и способов воздействия на них.

Меры информации.

Информационные меры отвечают трем основным направлениям в теории информации: структурному, статистическому, семантическому.

Структурная теория применяется: для оценки возможностей аппаратуры ИС (каналов связи, запоминающих и регистрирующих устройств) вне зависимости от условий их применения. В структурной теории различаются геометрическая, комбинаторная и аддитивная меры информации.

Геометрическая мера. Определение количества информации геометрическим методом сводится к измерению длины линии, площади или объема геометрической модели данного информационного комплекса в количестве дискретных единиц – определенных выше квантов. Геометрическим методом определяется потенциальное, т.е. максимально возможное количество информации в заданных структурных габаритах - информационной емкости исследуемой части ИС. Информационная емкость может быть представлена числом, показывающим, какое количество квантов содержится в полном массиве информации.

Геометрическую меру можно применять не только для оценки информационной емкости, но и для оценки количества информации, содержащейся в отдельном сообщении. Если о величине, отображаемой сообщением, известно, что она имеет максимальное значение из того ряда сообщений, которое она уже принимала ранее, то можно считать, что количество информации, содержащейся как в этом, так и в более ранних сообщениях, определяется числом квантов, содержащихся в максимальном значении.

К комбинаторной мере целесообразно прибегать тогда, когда требуется оценить возможность передачи информации при помощи различных комбинаций информационных элементов. Количество информации вычисляется как количество комбинаций элементов. Комбинирование возможно в комплексах с неодинаковыми элементами, переменными связями или разнообразными позициями. Одинаковые по всем своим признакам элементы могут стать неодинаковыми, если учесть их положение, позицию. В комбинаторике рассматриваются различные виды соединений элементов: Сочетание из  элементов по

элементов по  различается составом элементов, Сочетание с повторениями также различаются составом элементов, но элементы могут повторяться до

различается составом элементов, Сочетание с повторениями также различаются составом элементов, но элементы могут повторяться до  раз, Перестановка с повторением, Размещение из

раз, Перестановка с повторением, Размещение из  элементов по

элементов по  элементов различаются и составом элементов и их порядком, размещение с повторениями по

элементов различаются и составом элементов и их порядком, размещение с повторениями по  из

из  элементов.

элементов.

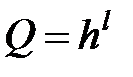

Аддитивная мера (мера Хартли). Глубиной  числа называется количество различных элементов (знаков), содержащееся в принятом алфавите. Глубина числа соответствует основанию системы счисления и кодирования. Один полный алфавит занимает одно числовое гнездо, глубина которого равна

числа называется количество различных элементов (знаков), содержащееся в принятом алфавите. Глубина числа соответствует основанию системы счисления и кодирования. Один полный алфавит занимает одно числовое гнездо, глубина которого равна  . В каждый данный момент реализуется только один какой-либо знак из h возможных.

. В каждый данный момент реализуется только один какой-либо знак из h возможных.

Длиной l числа называется количество числовых гнёзд, т.е. количество повторений алфавита необходимых и достаточных для представления чисел нужной величины. Длина числа соответствует разрядности системы счисления и кодирования. Один набор из l гнёзд алфавитов составляет одну числовую гряду, способную представить и хранить одно полное число длинной l. При глубине  и длине

и длине  количество чисел, которые можно представить с помощью числовой гряды, выразится формулой

количество чисел, которые можно представить с помощью числовой гряды, выразится формулой  (3.9), т.е. емкость гряды экспоненциально зависит от длины числа

(3.9), т.е. емкость гряды экспоненциально зависит от длины числа  .

.

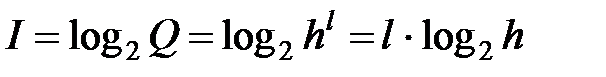

Хартли ввёл аддитивную логарифмическую меру, позволяющую вычислить количество информации в двоичных единицах битах. Для этого берется не само число  , а его двоичный алгоритм

, а его двоичный алгоритм  (3.10),

(3.10),  обозначает количество информации Хартли.

обозначает количество информации Хартли.

Статистическая теория оперирует понятием энтропии как меры неопределенности учитывающей вероятность появления, а следовательно, и информативность тех или иных сообщений.

Неопределённость каждой ситуации характеризуется величиной называемой энтропией.

Понятие энтропии распространилось на ряд областей знаний.

Ансамблем называется полная группа событий, или, иначе поле совместных событий с известным распределением вероятностей, составляющих в сумме единицу. Энтропия ансамбля есть количественная мера его неопределённости а следовательно и информативности.

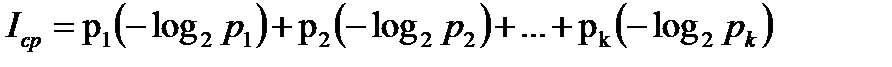

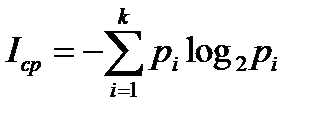

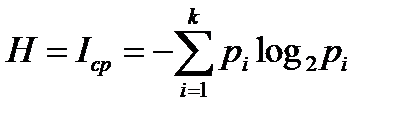

В статистической теории информации предложенной Шенноном энтропия количественно выражается как средняя функция множества вероятностей каждого из возможных исходов опыта.

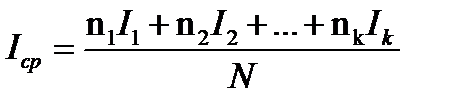

Пусть имеется всего N возможных исходов опыта, из них k разных, и i –й исход ( ) повторяется

) повторяется  раз и вносит информацию количество которой оценивается как

раз и вносит информацию количество которой оценивается как  . Тогда средняя информация доставляемая одним опытом,

. Тогда средняя информация доставляемая одним опытом,  (4.4)

(4.4)

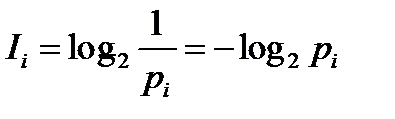

Но количество информации в каждом исходе связанно с его вероятностью  и выражается в двоичных единицах (битах) через логарифм

и выражается в двоичных единицах (битах) через логарифм  (4.5)

(4.5)

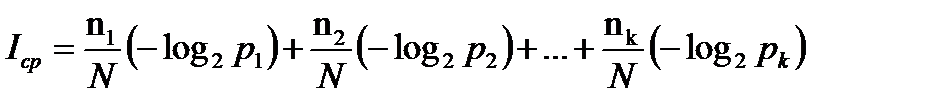

Тогда  (4.7)

(4.7)

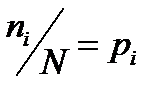

Но отношение  представляет собой частоты повторения исходов, а следовательно, могут быть заменены их вероятностями.

представляет собой частоты повторения исходов, а следовательно, могут быть заменены их вероятностями.  поэтому средняя информация в битах может быть выражена:

поэтому средняя информация в битах может быть выражена:

(4.8)

(4.8)

Или  (4.9)

(4.9)

Энтропия Шеннона Н, бит;  (4.10)

(4.10)

Способы квантования.

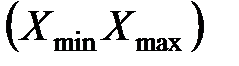

Непрерывный сигнал в системе координат

описывается в непрерывной функции

описывается в непрерывной функции  .

.

Переход от аналогового представления сигнала к цифровому, который дает в ряде случаев значительное преимущество при передаче, хранении и обработки информации, связан с квантованием (дискретизацией) сигнала  по времени и по уровню.

по времени и по уровню.

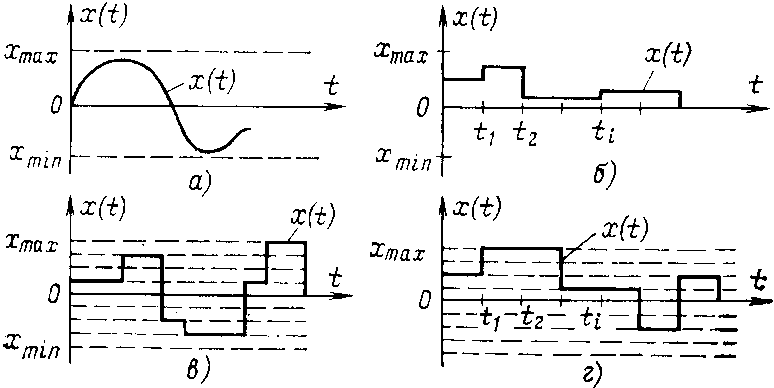

Разновидность сигналов, которые описываются функцией  .

.

Непрерывная функция непрерывного аргумента (а). Значения функции  , и аргумент

, и аргумент  заполняют конечные (или бесконечные) промежутки

заполняют конечные (или бесконечные) промежутки  и

и  соответственно.

соответственно.

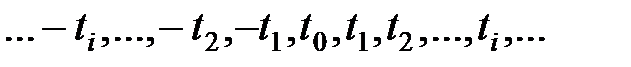

Непрерывная функция дискретного аргумента (б). Здесь значения функции  определяются на дискретном множестве значений аргумента

определяются на дискретном множестве значений аргумента  . Величина

. Величина  может принимать любое значение на отрезке

может принимать любое значение на отрезке  .

.

Дискретная функция непрерывного аргумента (в). В этом случае значения, которые может принимать функция  , образуют дискретный ряд чисел

, образуют дискретный ряд чисел  т.е. такой конечный или бесконечный ряд, в котором каждому числу

т.е. такой конечный или бесконечный ряд, в котором каждому числу  можно поставить соответствие интервал

можно поставить соответствие интервал  , внутри которого других чисел одного ряда нет. Значения аргумента

, внутри которого других чисел одного ряда нет. Значения аргумента  может быть любым на

может быть любым на  .

.

Дискретная функция дискретного аргумента (г). Значения, которые может принимать функция  , и аргумент

, и аргумент  образуют дискретный ряд чисел

образуют дискретный ряд чисел  и

и  , заполняющие отрезки

, заполняющие отрезки  и

и  соответственно.

соответственно.

Обычно операцию, переводящую непрерывный сигнал в дискретно-непрерывный, называют квантованием по времени или дискретизацией. Следовательно, дискретизация состоит в преобразовании сигнала  непрерывного аргумента

непрерывного аргумента  в сигнал

в сигнал  дискретного аргумента

дискретного аргумента  .

.

Квантование по уровню состоит в преобразовании непрерывного множества значений сигнала  в дискретное множество значений

в дискретное множество значений  ,

,  .

.

Совместное применение операций дискретизации и квантования позволяет преобразовать непрерывный сигнал  в дискретный по координатам

в дискретный по координатам  и

и  .

.

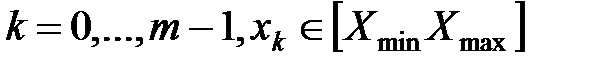

Дискретизация реализации сигнала  связано с заменой промежутка измерения независимой переменной некоторым множеством точек, т.е. операции дискретизации соответствует отображение

связано с заменой промежутка измерения независимой переменной некоторым множеством точек, т.е. операции дискретизации соответствует отображение  (5.1), где

(5.1), где  - функция, описывающая сигнал;

- функция, описывающая сигнал;  - функция, описывающая сигнал, полученный в результате дискретизации.

- функция, описывающая сигнал, полученный в результате дискретизации.

По значением функции  можно восстановить исходную функцию

можно восстановить исходную функцию  с некоторой погрешностью. Функцию, полученную в результате восстановления (интерполяции) по значениям функции

с некоторой погрешностью. Функцию, полученную в результате восстановления (интерполяции) по значениям функции  , называют воспроизводящей

, называют воспроизводящей  . Воспроизводящая функция

. Воспроизводящая функция  строится как взвешенная сумма некоторого ряда функций

строится как взвешенная сумма некоторого ряда функций  .

.  (5.2) причем коэффициенты

(5.2) причем коэффициенты  зависят от отсчетов

зависят от отсчетов  ,

,  .

.

При обработке сигналов дискретизация по времени должна производиться таким образом, чтобы по отсчетным значениям функции  можно было получить воспроизводящую функцию

можно было получить воспроизводящую функцию  , которая с заданной точностью отображает исходную функцию

, которая с заданной точностью отображает исходную функцию  .

.

При дискретизации сигналов приходится решать вопрос, каков должен быть шаг дискретизации  . При малых шагах дискретизации

. При малых шагах дискретизации  количество отсчетов функции на отрезке обработки будет большим и точность воспроизведения высокой.

количество отсчетов функции на отрезке обработки будет большим и точность воспроизведения высокой.

При больших шагах дискретизации  количество отсчетов уменьшится, но при этом, как правило, снижается точность восстановления.

количество отсчетов уменьшится, но при этом, как правило, снижается точность восстановления.

Оптимальной является такая дискретизация, которая обеспечивает представление исходного сигнала с заданной точностью при минимальном количестве выборов. В этом случае все отсчеты существенны для восстановления исходного сигнала.

Методы дискретизации и восстановления сигналов можно разделить на несколько групп в зависимости от принятых признаков классификации:

1. Регулярность отсчета (равномерные, неравномерные, случайные, адаптивные, с кратными и некратными интервалами).

2. Критерий оценки точности дискретизации и восстановления (максимальный, среднеквадратичный, интегральный, вероятностный).

3. Базисные функции (ряд Фурье, Котельникова, полиномы Чебышева, Лежандра, степенные полиномы, функции Уолша, Хаара, гипергеометрические).

4. Принцип приближения (интерполяция, экстраполяция, комбинированный).

Модуляция.

Сигналами называются физические процессы, параметры которых содержат информацию. Назначение сигналов: в каком-либо физическом процессе отобразить события, величины и функции.

Для образования сигналов используются фиксированный уровень (а), колебания (б) или импульсы (в) любой физической природы, которые рассматриваются как носители информации. В исходном состоянии эти носители представляют собой как бы чистую поверхность, подготовленную к нанесению необходимых данных, т.е. модуляции.

Модуляция заключается в том, что изменяется какой-либо один или несколько (сложная модуляция) параметров носителя в соответствии с передаваемой информацией. Эти параметры будем называть информационными.

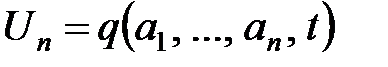

Если обозначить параметры носителя через  то носитель как функция времени может быть представлен в виде

то носитель как функция времени может быть представлен в виде

Модулированный носитель (сигнал) можно описать в виде

где  - переменная составляющая параметра носителя, несущая информацию, или модулирующая функция.

- переменная составляющая параметра носителя, несущая информацию, или модулирующая функция.

Для носителя первого типа (а)

ПМ - прямая модуляция - изменение постоянного напряжения или тока избегают называть модуляцией.

Для носителя второго типа (б)

AM - амплитудная модуляция, чм - частотная модуляция, ФМ - фазовая модуляция. Частотную и фазовую модуляцию иногда называют угловой модуляцией.

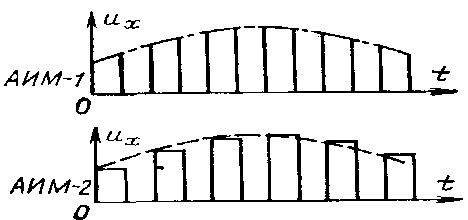

Для носитель третьего типа (в)

АИМ - амплитудно-импульсная модуляция, ЧИМ - частотно-импульсная модуляция, ВИМ - времяимпульсная модуляция, ШИМ - широтно-импульсная модуляция, ФИМ - фазоимпульсная модуляция, СИМ - счетно-импульсная модуляция, КИМ - кодоимпульсная модуляция.

ШИМ и ФИМ являются частными случаями ВИМ. Счетно-импульсная модуляция (СИМ) является частным случаем КИМ: информация передается числом импульсов.

Амплитудно-импульсная модуляция имеет две разновидности: AИM-I, при которой верхние участки импульсов (амплитуды) повторяют форму модулирующей функции (огибающей); АИМ-2, при которой амплитуда в пределах элементарного импульса остается неизменной, определяемой значением модулирующей функции в начале импульса.

Все импульсные сигналы могут иметь высокочастотное заполнение - сигнал несущей частоты. Чтобы подчеркнуть это обстоятельство, применяют двойные обозначения видов модуляции, например АИМ-ЧМ, КИМ-ЧМ и т.д., где второй вид модуляции относится к сигналам несущей частоты [1, 2, 3].

Для того, чтобы сигнал содержал информацию, он должен принципиально быть случайным. При описании сигнала некоторым количеством параметров часть из них может быть детерминированной, т.е. известной заранее, а честь случайной, т.е. несущей информацию. Часто представляет интерес изучение детерминированных характеристик сигнала, и тогда можно условно говорить о детерминированном сигнале. При длительном существовании сигнала определенной формы последний также может рассматриваться на определенном интервале как детерминированный.

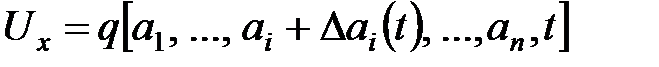

Случайный сигнал представляет собой модулированный носитель, у которого параметры  являются случайными функциями времени. Случайный сигнал, у которого лишь небольшое число переменных параметров

являются случайными функциями времени. Случайный сигнал, у которого лишь небольшое число переменных параметров  носит случайный характер, иногда называют квазидетерминированным. когда речь идет о случайных сигналах, рассматриваются лишь сигналы, пропорциональные информационной случайной функции

носит случайный характер, иногда называют квазидетерминированным. когда речь идет о случайных сигналах, рассматриваются лишь сигналы, пропорциональные информационной случайной функции  .

.

Виды восприятия информации.

Восприятием называется процесс целенаправленного извлечения и анализа информации о каком-либо объекте или процессе. Систематизируя наиболее важные виды восприятия информации, их можно расположить в таком порядке: 1) первичное восприятие информации и измерение величин; 2) анализ; 3) обнаружение и распознавание; 4) прогнозирование ситуаций.

Первичное восприятие. Восприятие информации от объектов осуществляется с помощью датчиков. Датчики называют также чувствительными элементами, воспринимающими элементами или рецепторами. В большинстве случаев датчики выражают входную информацию в виде эквивалентного электрического параметра, т.к. методы и средства измерения, передачи и обработки электрических сигналов обладают рядом достоинств; распространение получили пневматические сигналы.

Совокупность чувствительных элементов обеспечивает восприятие массовой информации со сложных объектов. При этом существенное значение имеют методы поиска и считывания информации.

Задачи обнаружения и распознавания возникают при восприятия информации. Процесс распознавания состоит в классификации явлений по имеющейся информации и отнесении воспринимаемой совокупности или вектора признаков  к области, характеризующей одно из состояний

к области, характеризующей одно из состояний  источника информации. С этой целью пространство признаков X разбивается по какому-либо критерию на

источника информации. С этой целью пространство признаков X разбивается по какому-либо критерию на  областей

областей  , соответствующих точкам пространства состояний

, соответствующих точкам пространства состояний  .

.

В сферу задач обнаружения и распознавания входит: 1) определение границ областей Xt;

2) нахождение оптимальных алгоритмов классификации.

Измерение. Измеряемую величину часто определяют, по значению другой величины, связанной с ней функциональной зависимостью.

Принципиальная возможность осуществления измерений ограничивается порогом чувствительности датчика и мощностью, необходимой для получения соответствующей информации. Большое значение имеют их динамические свойства.

При выполнении измерения пользуются измерительным преобразованием по одному из трех методов: прямого, следящего или развертывающего.

Структурная схема метода прямого измерительного преобразования образуется рядом последовательно соединенных звеньев без обратных связей и цепей сравнения. При прямом преобразовании измерение связано с отбором мощности от первичной измерительной цепи. Результирующий коэффициент усиления преобразователя определяется произведением коэффициентов усиления всех составляющих звеньев, а на результирующую погрешность преобразователя влияют погрешности всех звеньев. Добиться высокой точности измерения методом прямого преобразования сложно.

Два других метода измерительного преобразования основаны на автоматической компенсации измеряемой величины и позволяют получить более высокую точность.

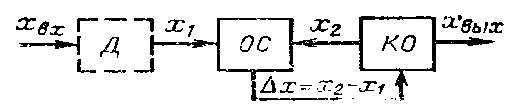

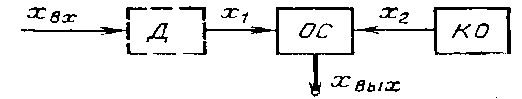

Следящий метод измерительного преобразования сочетает в себе высокую точность и чувствительность и позволяет обеспечить большую мощность на выходе, которая достаточна не только для индикации и регистрации, но и для решения задач автоматического регулирования различных процессов. Отличие: наличие звена обратного преобразования выходной величины во входную величину того же рода, что и преобразуемая входная величина, и их сравнение. Д - датчик, ОС - орган сравнения, КО -компенсирующий орган.

Преобразованная измеряемая величина  сравнивается с компенсирующей величиной х2. Разность

сравнивается с компенсирующей величиной х2. Разность  воздействует на компенсирующий орган КО таким образом, чтобы свести этот сигнал рассогласования к нулю. В момент идеальной компенсаций мощность от измерительной цепи не отбирается. Однако при наличии у любого реального органа сравнений ОС зоны нечувствительности может иметь, место незначительный отбор мощности. Нелинейность характеристики органа сравнения за пределами зоны нечувствительности на вид функции преобразования влияния не оказывает. Погрешность при градуировке учесть невозможно, но ее можно уменьшить путем увеличение коэффициента усиления К органа сравнения.

воздействует на компенсирующий орган КО таким образом, чтобы свести этот сигнал рассогласования к нулю. В момент идеальной компенсаций мощность от измерительной цепи не отбирается. Однако при наличии у любого реального органа сравнений ОС зоны нечувствительности может иметь, место незначительный отбор мощности. Нелинейность характеристики органа сравнения за пределами зоны нечувствительности на вид функции преобразования влияния не оказывает. Погрешность при градуировке учесть невозможно, но ее можно уменьшить путем увеличение коэффициента усиления К органа сравнения.

При развертывающем методе измерительного преобразования измеряемая величина циклически сравнивается с другой величиной такого же рода, изменяющейся по определенному (чаще линейному) закону Измеряемая и компенсируемая величины могут быть представлены электрическими напряжениями, силами, потоками радиации. В момент компенсации срабатывает орган сравнения.

Погрешность нелинейности может быть частично компенсирована смещением нулевого уровня выходного сигнала, снижением погрешности нелинейности заключается в увеличении коэффициента усиления. Вместе с тем метод развертывающего преобразования уступает следящему преобразованию в том, что допускает только дискретное во времени отображение входной величины

Анализ. Все автоматические анализаторы характеризуются тем, что получают информацию по нескольким координатам. При двух координатах первой является шкала анализа; вторая координата используется для количественной оценки каждой выделенной компоненты.

В анализаторах колебаний и анализаторах спектра случайных процессов признаком разделения является частота колебаний, а признаком измерения - амплитуда или средняя мощность каждой гармонической составляющей сложного колебательного процесса.

На выходе измерителя фиксируются явления, используемые для регистрации. Измерители представляют собой датчики, или чувствительные элементы, от которых могут работать исполнительные преобразователи регистрирующих узлов анализаторов.

В дискретных системах можно обойтись одним измерителем при наличии ряда анализирующих ячеек, если воспользоваться переключателем, или же одним исполнительным преобразователем в регистрирующем устройстве с переключателем, обслуживающем ряд измерителей.

Особое место занимают анализаторы случайных процессов, предназначенные для получений обобщенных статистических характеристик источника информации. Эти характеристики помогают понять сущность наблюдаемых явлений, выявить причинно-следственные связи, прогнозировать поведение источника, облегчают восприятие информации человеком

7. Каналы передачи информаци.