ГЛАВА 3. МОДЕЛЬ МНОЖЕСТВЕННОЙ

ЛИНЕЙНОЙ РЕГРЕССИИ

Основные понятия и уравнения множественной регрессии

На любой экономический показатель чаще всего оказывает влияние не один, а несколько совокупно действующих факторов. Например, объем реализации (Y) для предприятий оптовой торговли может определяться уровнем цен (Х 1), числом видов товаров (Х 2), размером торговой площади (Х 3) и товарных запасов (Х 4). В целом объем спроса на какой-либо товар определяется не только его ценой (Х 1), но и ценой на конкурирующие товары (Х 2), располагаемым доходом потребителей (Х 3), а также некоторыми другими факторами. Показатель инновационной активности современных предприятий зависит от затрат на исследования и разработки (Х 1), на приобретение новых технологий (Х 2), на приобретение программных продуктов и средств (Х 3) и обучение и переподготовку кадров [7,28]. В этих случаях возникает необходимость рассмотрения моделей множественной (многофакторной, многомерной) регрессии [28].

Модель множественной линейной регрессии является естественным обобщением парной (однофакторной) линейной регрессионной модели. В общем случае ее теоретическое уравнение имеет вид:

(3.1)

(3.1)

где Х 1, Х 2,…, Хm – набор независимых переменных (факторов-аргументов); b 0, b 1, …, bm – набор (m + 1) параметров модели, подлежащих определению; ε – случайное отклонение (ошибка); Y – зависимая (объясняемая) переменная.

Для индивидуального i -го наблюдения (i = 1, 2, …, n) имеем:

(3.2)

(3.2)

или

. (3.3)

. (3.3)

Здесь bj называется j - м теоретическим коэффициентом регрессии (частичным коэффициентом регрессии).

Аналогично случаю парной регрессии, истинные значения параметров (коэффициентов) bj по выборочным данным получить невозможно. Поэтому для определения статистической взаимосвязи переменных Y и Х 1, Х 2, …, Хm оценивается эмпирическое уравнение множественной регрессионной модели

(3.4)

(3.4)

в котором  ,

,  – оценки соответствующих теоретических коэффициентов регрессии; е – оценка случайного отклонения ε.

– оценки соответствующих теоретических коэффициентов регрессии; е – оценка случайного отклонения ε.

Оцененное уравнение (3.4) в первую очередь должно описывать общий тренд (направление, тенденцию) изменения зависимой переменной Y. При этом необходимо иметь возможность рассчитать отклонения от этого тренда.

Для решения задачи определения оценок параметров множественной линейной регрессии по выборке объема n необходимо выполнение неравенства n ³ m + 1 (m – число регрессоров). В данном случае число v = n - m - 1 будет называться числом степеней свободы. Отсюда для парной регрессии имеем v = n - 2. Нетрудно заметить, что если число степеней свободы невелико, то и статистическая надежность оцениваемой формулы невысока. На практике принято считать, что достаточная надежность обеспечивается в том случае, когда число наблюдений по крайней мере в три раза превосходит число оцениваемых параметров k = m + 1. Обычно, статистическая значимость парной модели наблюдается при n ≥ 7.

Самым распространенным методом оценки параметров уравнения множественной линейной регрессионной модели является метод наименьших квадратов (МНК). Напомним (см. раздел 2.4.1), что надежность оценок и статистических выводов, полученных с использованием МНК, обеспечивается при выполнении предпосылок Гаусса-Маркова. В случае множественной линейной регрессии к предпосылкам 1–4 необходимо добавить еще одну (пятую) – отсутствие мультиколлинеарности, что означает отсутствие линейной зависимости между объясняющими переменными в функциональной или статистической форме. Более подробно мультиколлинеарность объясняющих переменных будет рассмотрена в разделе (3.4). Модель, удовлетворяющая предпосылкам МНК, называется классической нормальной моделью множественной регрессии.

На практике часто бывает необходимо оценить силу влияния на зависимую переменную различных объясняющих (факторных) переменных. В этом случае используют стандартизованные коэффициенты регрессии  и средние коэффициенты эластичности

и средние коэффициенты эластичности  .

.

Стандартизированный коэффициент регрессии определяется по формуле:

(3.5)

(3.5)

где S (xj) и S (y) – выборочные средние квадратичные отклонения (стандарты) соответствующей объясняющей и зависимой переменных.

Средний коэффициент эластичности

(3.6)

(3.6)

показывает, на сколько процентов (от средней) изменится в среднем зависимая переменная Y при увеличении только j -й объясняющей переменной на 1 %.

Для модели с двумя объясняющими (факторными) переменными  , после нахождения оценок

, после нахождения оценок  , уравнение определяет плоскость в трехмерном пространстве. В общем случае m независимых переменных геометрической интерпретацией модели является гиперплоскость в гиперпространстве.

, уравнение определяет плоскость в трехмерном пространстве. В общем случае m независимых переменных геометрической интерпретацией модели является гиперплоскость в гиперпространстве.

Оценка параметров регрессионной модели

Для нахождения оценок параметров bj множественной линейной регрессионной модели (коэффициентов  эмпирического уравнения регрессии) используется метод наименьших квадратов (МНК). Суть МНК заключается в минимизации суммы квадратов отклонений наблюдаемых выборочных значений yi зависимой переменной Y от их модельных оценок

эмпирического уравнения регрессии) используется метод наименьших квадратов (МНК). Суть МНК заключается в минимизации суммы квадратов отклонений наблюдаемых выборочных значений yi зависимой переменной Y от их модельных оценок  . Отклонение еi, соответствующее уравнению регрессии в i -м наблюдении (i = 1, 2, …, n), рассчитывается по формуле:

. Отклонение еi, соответствующее уравнению регрессии в i -м наблюдении (i = 1, 2, …, n), рассчитывается по формуле:

. (3.7)

. (3.7)

Тогда для нахождения коэффициентов  по МНК минимизируется следующая функция m + 1 переменных:

по МНК минимизируется следующая функция m + 1 переменных:

. (3.8)

. (3.8)

Необходимым условием минимума функции G является равенство нулю всех ее частных производных по  Частные производные квадратичной функции (3.8) являются линейными функциями относительно параметров:

Частные производные квадратичной функции (3.8) являются линейными функциями относительно параметров:

. (3.9)

. (3.9)

Приравнивая (3.9) к нулю, получаем систему m + 1 линейных нормальных уравнений с m + 1 неизвестными для определения параметров модели:

(3.10)

(3.10)

где j = 1, 2, …, m – определяет набор регрессоров.

Следует заметить, что включение в модель новых объясняющих переменных усложняет расчет коэффициентов множественной линейной регрессии путем решения системы (3.10) по сравнению с парной моделью. Система из трех уравнений, соответствующая модели с двумя объясняющими переменными  , может быть легко решена методом определителей. Однако в общем виде решение системы (3.10) и анализ множественной регрессионной модели наиболее целесообразно проводить в векторно-матричной форме [15,17].

, может быть легко решена методом определителей. Однако в общем виде решение системы (3.10) и анализ множественной регрессионной модели наиболее целесообразно проводить в векторно-матричной форме [15,17].

Тогда, вводя матричные обозначения, запишем:

,

,  ,

,  .

.

Здесь Y – n -мерный вектор-столбец наблюдений зависимой переменной; Х – матрица размерности n · (m + 1) значений объясняющих переменных xij, в которой единица соответствует переменной при свободном члене  ;

;  – вектор-столбец размерности m + 1 оценок параметров модели (коэффициентов уравнения регрессии); е – вектор-столбец размерности n отклонений выборочных (реальных) значений yi зависимой переменной, от значений оценок

– вектор-столбец размерности m + 1 оценок параметров модели (коэффициентов уравнения регрессии); е – вектор-столбец размерности n отклонений выборочных (реальных) значений yi зависимой переменной, от значений оценок  , получаемых по уравнению регрессии.

, получаемых по уравнению регрессии.

В матричной форме модель (3.1) примет вид:

Y = XB + e. (3.11)

Оценкой этой модели по выборочным данным является уравнение (эмпирическая модель)

. (3.12)

. (3.12)

Предпосылки МНК (см. раздел 2.4.1.) в матричной форме можно записать следующим образом:

1. M (e) = 0; 2. D (e) = σ2 I; 3. Матрица ковариаций V (e) = M (e · e T) = σ2 E,

где e =  – вектор-столбец случайных отклонений (ошибок);

– вектор-столбец случайных отклонений (ошибок);

I =  – (n · 1) вектор;

– (n · 1) вектор;

E = En×n =  – единичная матрица;

– единичная матрица;

– матрица ковариаций или ковариационная матрица вектора случайных отклонений, которая является многомерным аналогом дисперсии одной переменной и в которой, если предпосылка о некоррелированности отклонений e i и e j выполняется, все элементы, не лежащие на главной диагонали, равны нулю, а элементы главной диагонали равны одной и той же дисперсии D (e i) = σ2; 4. e – нормально распределенный случайный вектор, т. е. e ~ N (0, σ2Е); 5. r (X) = m + 1 > n – детерминированная матрица объясняющих переменных (регрессоров) имеет ранг r, равный числу определяемых параметров модели m + 1, кроме того, число имеющихся наблюдений каждой из объясняющих переменных и зависимой переменной превосходит ранг матрицы Х.

– матрица ковариаций или ковариационная матрица вектора случайных отклонений, которая является многомерным аналогом дисперсии одной переменной и в которой, если предпосылка о некоррелированности отклонений e i и e j выполняется, все элементы, не лежащие на главной диагонали, равны нулю, а элементы главной диагонали равны одной и той же дисперсии D (e i) = σ2; 4. e – нормально распределенный случайный вектор, т. е. e ~ N (0, σ2Е); 5. r (X) = m + 1 > n – детерминированная матрица объясняющих переменных (регрессоров) имеет ранг r, равный числу определяемых параметров модели m + 1, кроме того, число имеющихся наблюдений каждой из объясняющих переменных и зависимой переменной превосходит ранг матрицы Х.

Выполнение пятой предпосылки означает линейную независимость объясняющих переменных (линейную независимость столбцов матрицы Х), т. е. отсутствие функциональной мультиколлинеарности.

Наша задача заключается в нахождении вектора оценок  по МНК, который, при выполнении предпосылок 1–5, обладает наименьшим рассеянием относительно параметра B.

по МНК, который, при выполнении предпосылок 1–5, обладает наименьшим рассеянием относительно параметра B.

Воспользовавшись известными соотношениями матричной алгебры и правилами дифференцирования по векторному аргументу, получим необходимое условие минимума функции G (равенство нулю вектор-столбца частных производных  )

)

(3.13)

(3.13)

откуда вытекает система нормальных уравнений в матричной форме для определения вектора

(3.14)

(3.14)

где ХТ – транспонированная матрица.

Решением уравнения (3.14) является вектор оценок:

(3.15)

(3.15)

где (ХТХ)-1 – матрица, обратная ХТХ; ХТY – вектор-столбец свободных членов системы.

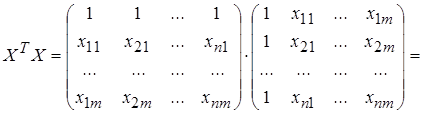

Найдем матрицы, входящие в матричное уравнение (3.14):

. (3.16)

. (3.16)

Матрица ХТХ образует симметричную матрицу сумм первых степеней, квадратов и попарных произведений n наблюдений объясняющих переменных.

. (3.17)

. (3.17)

Матрица ХТХ представляет вектор-столбец произведений n наблюдений объясняющих и зависимой переменных.

Зная вектор коэффициентов множественной линейной регрессии  (3.15), находим оценку (групповую среднюю)

(3.15), находим оценку (групповую среднюю)  зависимой переменной Y при заданном векторе значений объясняющей (факторной) переменной

зависимой переменной Y при заданном векторе значений объясняющей (факторной) переменной  [11,28].

[11,28].

Пример 3.1. Для иллюстрации получим формулы для расчета коэффициентов парной регрессии  (m = 1), используя матричные обозначения.

(m = 1), используя матричные обозначения.

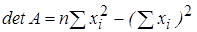

В соответствии с (3.17) определим матрицу А -1 = (ХТХ)-1 по формуле:

,

,

где detA – определитель матрицы ХТХ; A *– присоединенная матрица (транспонированная матрица алгебраических дополнений).

Для данного примера:

.

.

,

,  .

.

.

.

Тогда вектор оценок  для частного случая m = 1 определяется как:

для частного случая m = 1 определяется как:

,

,

откуда следуют формулы (2.11) для определения параметров парной регрессионной модели.